OpenVINO™ 工作流程整合工具

QNAP的OpenVINO™Workflow Consolidation Tool(简称OWCT)为融合OpenVINO™执行流程的协同工具。此应用程序采用Intel®OpenVINO™开发工具包技术,专为深度学习应用打造,可将训练好的AI模型部署到目标平台上进行推论操作,协助企业组织以经济、效率的方式快速部署计算机视觉(Computer Vision)和深度学习解决方案。

本文引用地址://m.amcfsurvey.com/article/202108/427282.htm训练和推论

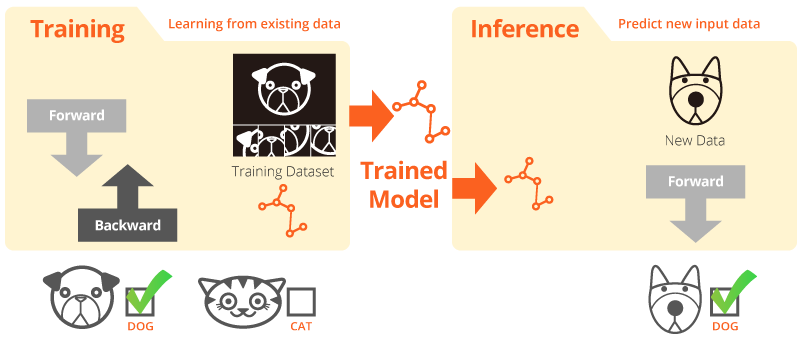

「训练」指的是让系统通过一组有限数据进行学习的过程;而「推论」则是运用已经训练完成的模型,在更广大的环境里实际预测正确的结果。

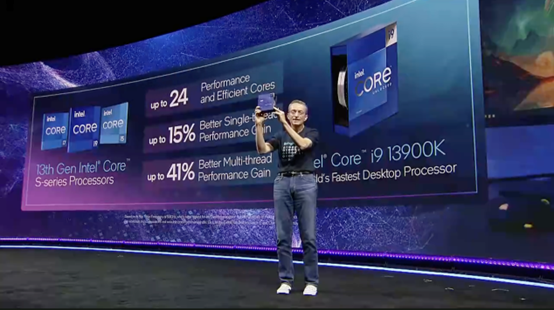

Intel®OpenVINO™开发工具包

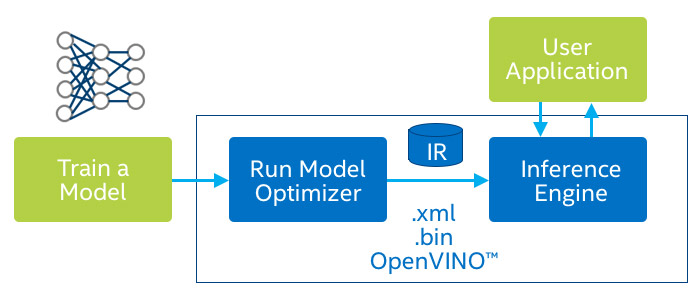

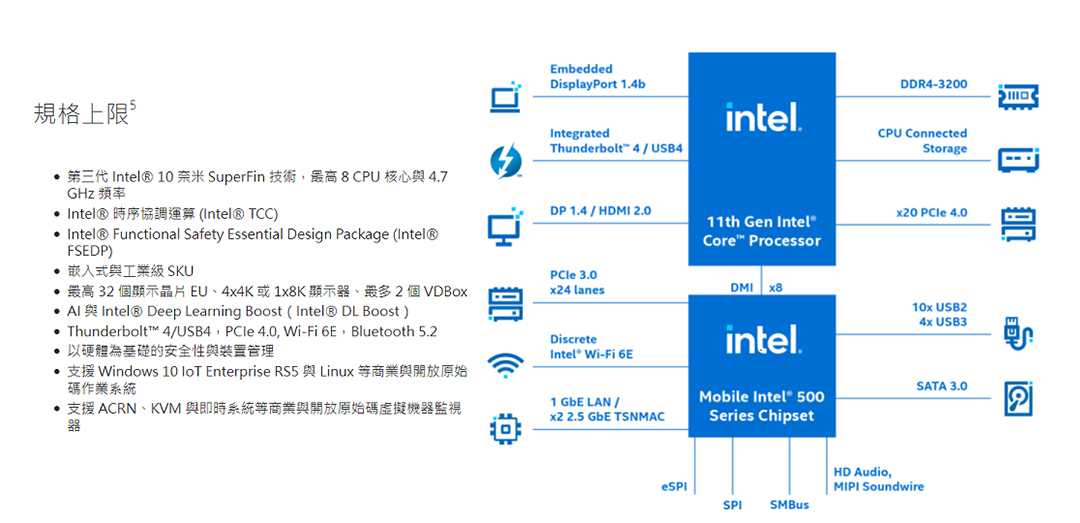

开源的OpenVINO™工具套件可让您的企业将计算机视觉与深度学习解决方案快速又有效地实施于多种应用程序上。其支持硬件加速装置以带来深度学习推论的加速能力,并广泛支持Intel®平台装置(包含CPU、GPU、FPGA及VPU等硬件加速芯片)。重要元素包括:

*Intel®深度学习开发工具包(模型优化器和推论引擎)

*针对OpenCV和OpenVX的优化功能

*超过15个范例程序代码和预先训练好的模型,可节省宝贵的开发时间

快速进行您的计算机视觉AI推论

使用OpenVINO™Workflow Consolidation Tool(OWCT)的主要优点:

部署快速

OpenVINO™工具套件内含开源的代码库,可协助缩短开发时间,并简化深度学习推论和计算机视觉解决方案的部署流程。

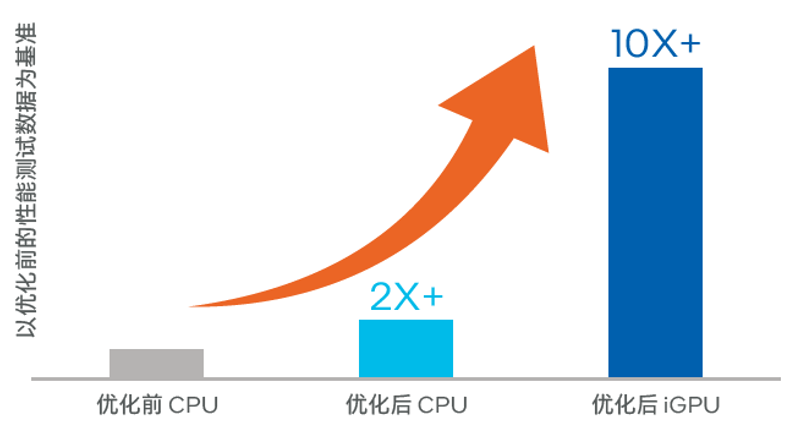

模型优化

模型优化器可将训练模型转换成IR文件格式(Intermediate Representation),并协助去除已训练好模型中的冗余参数,提升推论速度数十倍到百倍。

图形用户接口

OWCT提供图形用户接口,让用户可轻易地使用OpenVINO™功能,检视呈现的影像画面,并下载推论结果存档。

使用默认模型加速开发时间

除了找寻现成的AI模型或自行训练专属的模型,OpenVINO™工具套件也提供Intel®预先训谏及优化好的神经网络模型让用户套用,并且是推论引擎可直接读取并执行推论。

使用预先训练好的模型

OpenVINO™工具套件包含两种优化的模型组。您可以直接采用这些模型应用至您的推论环境,节省宝贵的开发时间。

*年龄&性别辨识

*十字路口

*头部位置

*安全标志、路障

*交通工具特征辨识

*以及更多…

使用您自己训练的模型

汇入您自行训练的模型,并利用模型优化器和推论引擎的优化功能,如此一来,您便能轻松地在现有或是未来的Intel®平台装置执行计算机视觉推论,满足AI应用需求。OpenVINO™工具套件可兼容使用Caffe或TensorFlow框架所开发的训练模型。

加速卡助力深度学习推论

OpenVINO™工具套件支持Intel®平台的硬件加速器(CPU、GPU、FPGA和VPU),透过统一的API接口对指定的加速硬件激发效能潜力。

评论