亿欧智库:2022年中国AI芯片行业深度研究

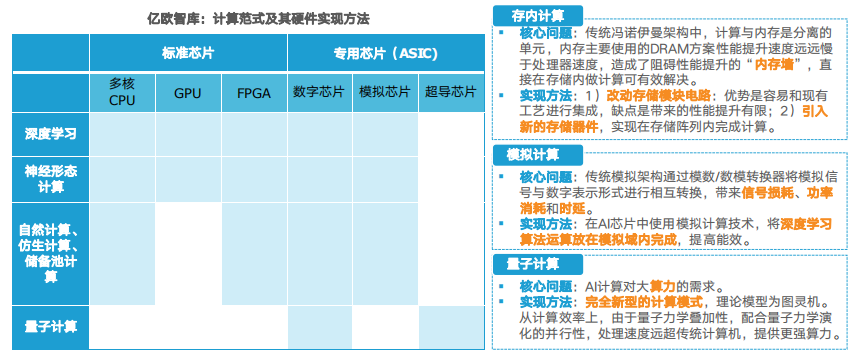

四大类人工智能芯片(GPU、ASIC、FGPA、类脑芯片)及系统级智能芯片在国内的发展进度层次不齐。用于云端的训练、推断等大算力通用 芯片发展较为落后;适用于更多垂直行业的终端应用芯片如自动驾驶、智能安防、机器人等专用芯片发展较快。超过80%中国人工智能产业链企 业也集中在应用层。

本文引用地址://m.amcfsurvey.com/article/202203/432210.htm无芯片不AI , 以AI芯片为载体实现的算力是人工智能发展水平的重要衡量标准。

广义的AI芯片:专门用于处理人工智能应用中大量计算任务的模块,即面向人工智能领域的芯片均被称为AI芯片。狭义的AI芯片:针对人工智能算法做了特殊加速设计的芯片。

《2022中国AI芯片行业研究报告》报告将对针对狭义的AI芯片即人工智能算法做特殊加速设计的四种主流芯片GPU、ASIC、FPGA、类脑芯片以及系统级AI芯片技术、实现 AI的主流算法及在场景中的应用情况进行解析。

人工智能算法需要在计算机设备上实现,而芯片又是计算机设备运作的核心零件,因此AI芯片的发展主要依赖两个领域:第一个是模仿人脑建 立的数学模型与算法,第二个是半导体集成电路即芯片。优质的算法需要足够的运算能力也就是高性能芯片的支持。

亿欧智库2019年发布AI芯片行业研究报告认为,人工智能于芯片的发展分为三个阶段:第一阶段由于芯片算力不足,神经网络算法未能落 地;第二阶段芯片算力提升,但仍无法满足神经网络算法需求;第三阶段,GPU和新架构的AI芯片促进了人工智能的落地。

目前,随着第三代神经网络的出现,弥合了神经科学与机器学习之间的壁垒,AI芯片正在向更接近人脑的方向发展。

AI芯片一般泛指所有用来加速AI应用,尤其是用在基于神经网络的深度学习中的硬件。

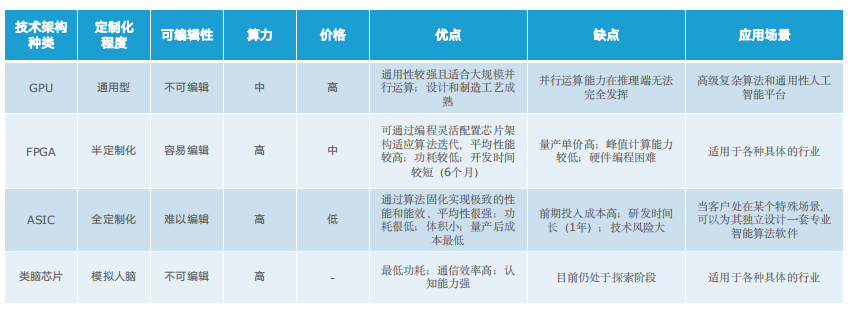

AI芯片根据其技术架构,可分为GPU、FPGA、ASIC及类脑芯片,同时CPU可执行通用AI计算,其中类脑芯片还处于探索阶段。

AI芯片根据其在网络中的位置可以分为云端AI芯片、边缘及终端AI芯片;根据其在实践中的目标,可分为训练(training)芯片和推理 (inference)芯片。

云端主要部署训练芯片和推理芯片,承担训练和推理任务,具体指智能数据分析、模型训练任务和部分对传输带宽要求比高的推理任务;边缘 和终端主要部署推理芯片,承担推理任务,需要独立完成数据收集、环境感知、人机交互及部分推理决策控制任务。

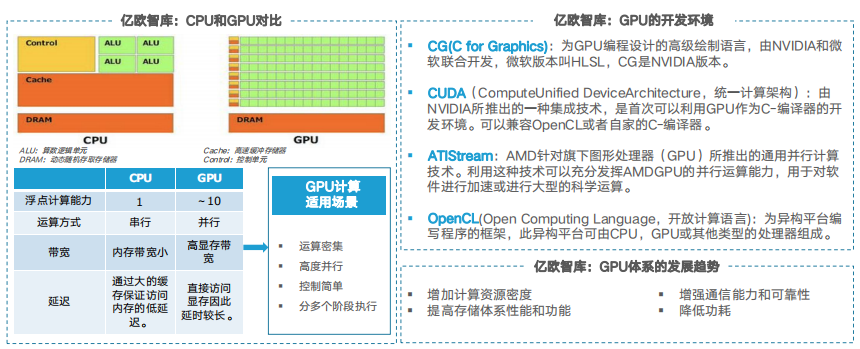

GPU(Graphics Processing Unit)图形处理器最初是一种专门用于图像处理的微处理器,随着图像处理需求的不断提升,其图像处理能力也得 到迅速提升。目前,GPU主要采用数据并行计算模式完成顶点渲染、像素渲染、几何渲染、物理计算和通用计算等任务。因其超过CPU数十倍 的计算能力,已成为通用计算机和超级计算机的主要处理器。其中通用图形处理器GPGPU(GeneralPropose Computing on GPU)常用于数据 密集的科学与工程计算中。

英伟达与AMD仍占据GPU霸主地位,2018年至今,国产GPU也积极发展中,已有部分产品落地。

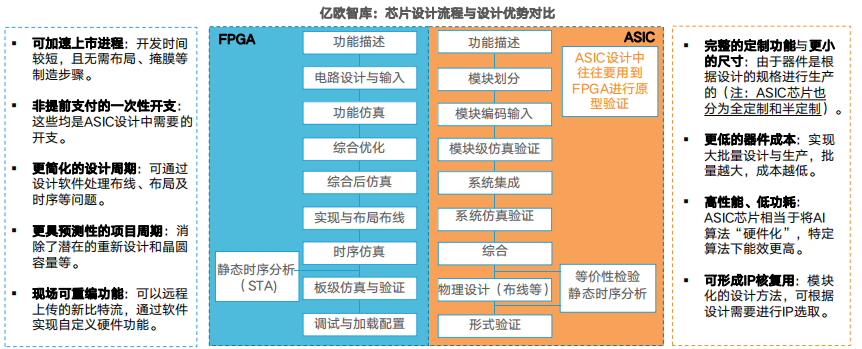

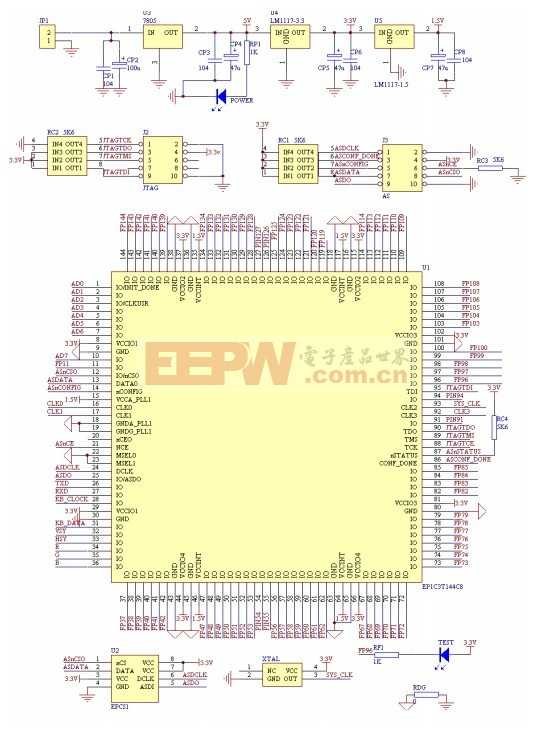

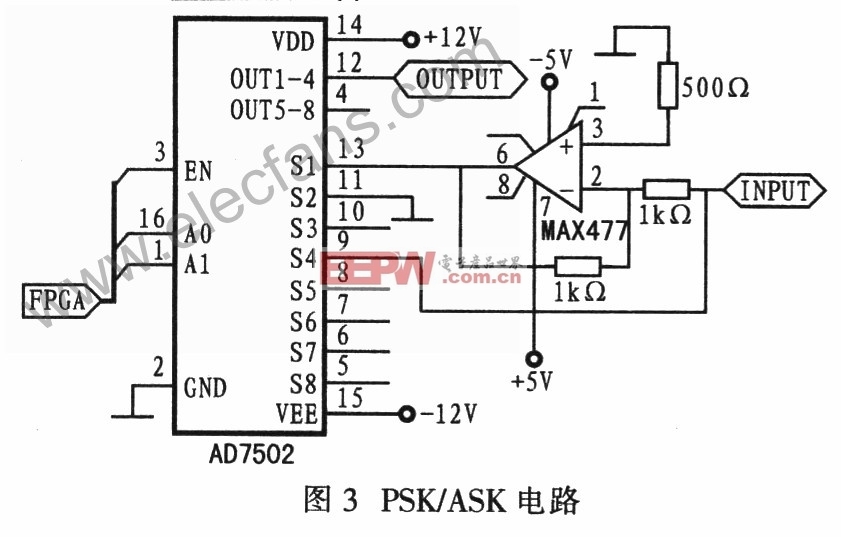

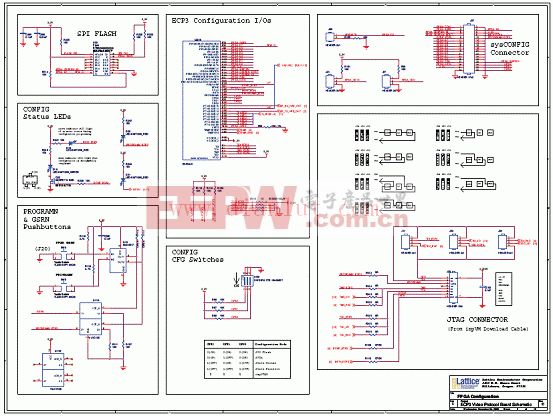

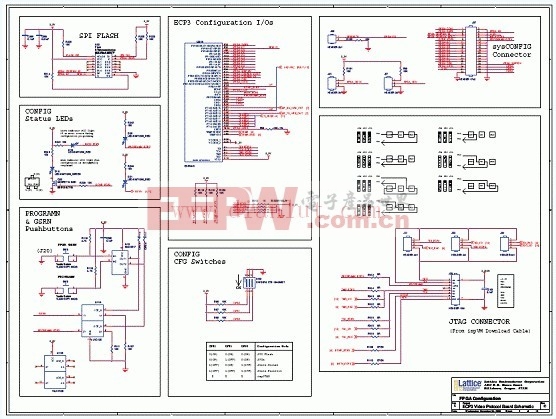

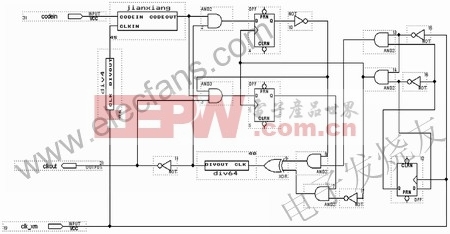

FPGA全称是Field Programmable Gate Array:可编程逻辑门阵列,是一种“可重构”芯片,具有模块化和规则化的架构,主要包含可编程 逻辑模块、片上储存器及用于连接逻辑模块的克重购互连层次结构。在较低的功耗下达到GFLOPS数量级的算力使之成为并行实现人工神经 网络的替代方案。

ASIC(Application-Specific Integrated Circuit)是指应特定用户要求和特定电子系统的需要而设计、制造的集成电路。ASIC从性能、能效、成本均极大的超越了标准芯片,非常适合AI计算场景,是当前大部分AI初创公司开发的目标产品。

FPGA具有开发周期短,上市速度快,可配置性等特点,目前被大量的应用在大型企业的线上数据处理中心和军工单位。ASIC一次性成本远远 高于FPGA,但由于其量产成本低,应用上就偏向于消费电子,如移动终端等领域。

目前,处理器中开始集成FPGA,也出现了可编程的ASIC,同时,随着SoC的发展,两者也在互相融合。

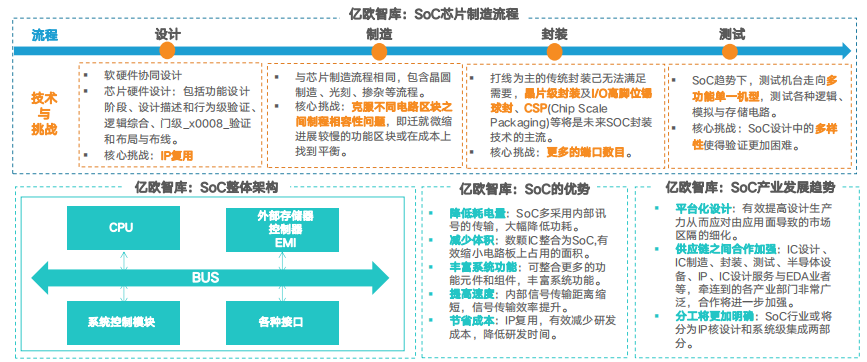

在手机、可穿戴设备等端设备中,很少有独立的芯片,AI加速将由SoC上的一个IP实现。

SoC(System-on-chip,片上系统)作为ASIC设计方法学中的新技术,始于20世纪90年代中期,是以嵌入式系统为核心,以IP复用技术为基 础,集软、硬件于一体的集成芯片。在一个芯片上实现信号的传输、存储、处理和I/O等功能,包含嵌入软件及整个系统的全部内容。

由于高集成效能,SoC已经成为微电子芯片发展的必然趋势。

CPU/GPU/GFPGA/ASIC及SoC是目前用的较多的AI芯片,此类AI芯片大多是基于深度学习,也就是深度神经网络(DNN),以并行方式进 行计算的芯片,此类AI芯片又被称为深度学习加速器。

如今,模仿大脑结构的芯片具有更高的效率和更低的功耗,这类基于神经形态计算,也就是脉冲神经网络(SNN)的芯片为类脑芯片。

目前,部分企业产品已进入小批量试用阶段 ,类脑芯片最快将于2023年成熟,能效比有望较当前芯片提高2-3个数量级。

现在用于深度学习的AI芯片(包括CPU、GPU、FPGA、ASIC)为了实现深度学习的庞大乘积累加运算和并行计算的高性能,芯片面积越做越 大,带来了成本和散热等问题。AI芯片软件编程的成熟度、芯片的安全,神经网络的稳定性等问题也未能得到很好的解决,因此,在现有基础 上进行改进和完善此类AI芯片仍是当前主要的研究方向。

最终,AI芯片将近一步提高智能,向着更接近人脑的高度智能方向不断发展,并向着边缘逐步移动以获得更低的能耗。

AI硬件加速技术已经逐渐走向成熟。未来可能更多的创新会来自电路和器件级技术的结合,比如存内计算,类脑计算;或者是针对特殊的计 算模式或者新模型,比如稀疏化计算和近似计算,对图网络的加速;或者是针对数据而不是模型的特征来优化架构。

同时,如果算法不发生大的变化,按照现在AI加速的主要方法和半导体技术发展的趋势,或将在不远的将来达到数字电路的极限(约1到 10TFlops/W),往后则要靠近似计算,模拟计算,甚至是材料或基础研究上的创新。

评论