ICLR2023 | 阿卜杜拉国王科技大学最新发布,3D表示新网络:多视图+点云!(3)

VointConv是指对Voint空间上的操作进行卷积运算 。

- 它是一个可学习的函数,具有共享权重,并且在所有的Voint上进行操作。

- 输入是视图特征大小为 的数据,输出是视图特征大小为 的数据,其中包含了 层。

一个简单的VointConv操作的示例是将共享的多层感知机 ( MLP ) 应用于可见视图特征。

- 在第4.2节中,提供了更多关于这种操作的详细信息,导致了VointNet 的不同的变体。

VointNet 模型的目标是:获得可以随后被任何点云处理 pipeline 使用的多视图点云特征。

VointNet 模块 定义如下。

其中 是任意点卷积运算(例如共享 MLP 或 EdgeConv)。在将 VointMax 应用于视图特征以获得点特征之前,VointNet 使用学习到的 VointConv 转换各个视图特征。

用于 3D 点云处理的 VointNet **pipeline ** —— VointNet Pipeline for 3D Point Cloud Processing完整的 pipeline 如图 2 所示。损失可描述如下:

其中 :

- L 是在所有训练点 上定义的交叉熵 (CE) 损失, 定义了这些点的标签。

- 其他组件 均已在之前定义。

要联合学习的权重是 2D 主干 的权重和使用相同 3D 损失的 VointNet 的权重。可以选择添加 上的辅助 2D 损失以在图像级别进行监督。

对于分类,整个对象可以被视为单个 Voint,每个视图的全局特征将是该 Voint 的视图特征。

实验 Experiments实验设置 Experimental SetupDatasets 数据集本文对VointNet 进行了基准测试,使用了具有挑战性和现实性的ScanObjectNN数据集。该数据集包含三个变体,包括背景和遮挡,共有15个类别和2,902个点云。

对于形状检索任务,我们使用ShapeNet Core55作为ShapeNet的子集进行基准测试。该数据集包含51,162个带有55个对象类别标签的3D网格对象。根据MVTN的设置从每个网格对象中采样5,000个点来生成点云。

另外,对于形状部件分割任务,在ShapeNet Parts上进行了测试,它是ShapeNet的一个子集,包含来自16个类别和50个部分的16,872个点云对象。

对于遮挡鲁棒性测试,遵循MVTN的方法,在ModelNet40数据集上进行测试,该数据集由40个类别和12,311个3D对象组成。

Metrics 评估指标评估指标方面:

对于3D点云分类任务,展示了整体精度。

对于形状检索任务,使用测试查询的平均精度(mAP)进行评估。

对于语义分割任务,使用点云上的平均交并比(mIoU)进行评估。

对于部件分割任务,展示了实例平均mIoU(Ins. mIoU)。

作为基线方法,包括 PointNet、PointNet++和DGCNN 作为使用点云的基线。

还与一些基于多视图的方法进行了比较,包括 MVCNN、SimpleView和MVTN,用于分类和检索任务,并使用了一些基于多视图的分割方法(如标签融合和Mean Fusion)用于部件分割任务。

VointNet 变量等式 (3) 中的 VointNet 依赖于 VointConv 操作 作为基本构建块。

在这里,简要描述了 VointNet 使用的三个 操作示例。

共享多层感知器 (MLP)这是最基本的 VointConv公式。

对于层 ,视图 处的 Voint 的特征被更新到层 为:,其中 ρ 是共享 MLP,其权重为 ,然后是归一化和非线性函数(例如 ReLU)。

此操作独立应用于所有 Voint,并且仅涉及每个Voint 的可见视图特征。该公式扩展了 PointNet 的共享MLP 公式,以处理 Voints 的视图特征。

图卷积(GCN)通过创建一个连接到所有视图特征的虚拟中心节点来聚合它们的信息(类似于 ViT 中的 “cls” token 来为每个 Voint 定义一个全连接的图。

然后,图卷积可以被定义为共享 MLP(如上所述)但在所有视图特征之间的边缘特征上,然后是图形邻居上的最大池化。在最终输出之前使用额外的共享 MLP。

图注意力(GAT)图注意力操作可以像上面的 GCN 操作一样定义,但是在对它们进行平均之前,在图邻居的特征上学习注意力权重。共享 MLP 计算这些权重。

Implementation Details 实现细节Rendering and Unprojection. 渲染和非投影在pipeline 中选择来自 Pytorch3D的可微点云渲染器 R,因为它的速度和与Pytorch 库的兼容性。在尺寸为 的多视图图像上渲染点云。

根据点的法线值对点进行着色,如果法线不可用,则将它们保持为白色。按照与 (Wei et al, 2020;Hamdi et al, 2021) 类似的程序,视点设置在训练期间随机化(使用 个视图)并在测试中固定为球面视图(使用 个视图)。

Architectures 架构对于二维主干 C,使用 ViT-B(具有来自 TIMM 库的预训练权重)进行分类,使用 DeepLabV3进行分割。

在 3D 点云输出上使用 3D CE 损失以及在像素上定义损失时的 2D CE 损失。VointNet 架构的特征维度为 d = 64,深度在 中为 = 4 层。

主要结果基于VointNet (MLP),除非在第 6 节中另有说明,在第6 节中详细研究了 VointConv 和 C 的影响。

Training Setup 训练设置分两个阶段训练,首先在点的2D 投影标签上训练 2D 主干,然后端到端地训练整个pipeline,同时将训练重点放在 VointNet 部分。

使用 AdamW 优化器 ,初始学习率为 ,步长学习率为每 12 个epoch 33.3%,持续 40 个epoch 。

使用一个 NVIDIATesla V100 GPU 进行训练。不使用任何数据扩充。

有关训练设置(损失和渲染)、VointNet 和 2D 骨干架构的更多详细信息,请参见附录。

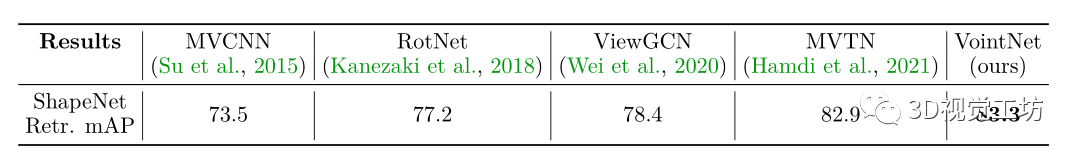

表3:3D 形状检索。

- 报告了 ShapeNet Core55 上的 3D 形状检索 mAP。

- VointNet 在此基准测试中取得了最先进的结果。

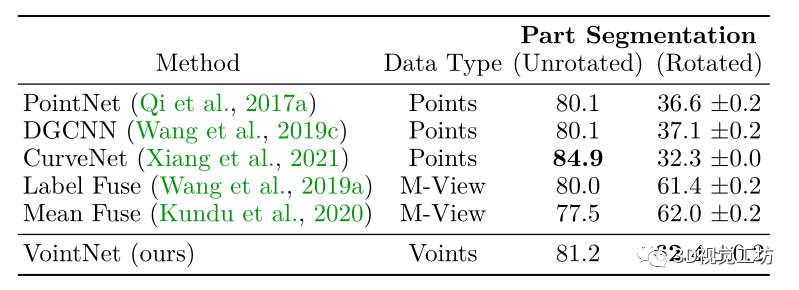

Results 结果表 4:ShapeNetPart 上的稳健 3D 部件分割。

在 ShapeNetPart 的 3D 分割中,VointNet 的 mIoU 与其他方法的对比。

Voint 的主要测试结果总结在表 2、3、4 和 5 中。在 3D 分类、检索和稳健的 3D 零件分割任务中实现了最先进的性能。

- 更重要的是,在 ScanObjectNN 和 ShapeNetParts 的真实旋转设置下,分别与点基线 相比,提高了 7.2% 以上的Acc和 25% mIoU 。

- 按照 Hamdi 等人 (2021) 的惯例,在基准表中报告了四次运行中的最佳结果,但附录中提供了详细结果。

表 2 报告了 ScanObjectNN 上 3D点云分类任务的分类精度。它将 VointNet 与其他最近的强大基线进行基准测试 。

- VointNet 展示了所有变体的最新结果,包括具有挑战性的 Hardest (PB_T50_RS) 变体,其中包含具有挑战性的旋转和平移对象场景。

- 该变体的性能提升 (+2.6%)非常显着,突出了 Voints 在具有挑战性的场景中的优势,并在第 5.4 节中进一步证实了结果。遵循与MVTN 中完全相同的程序。

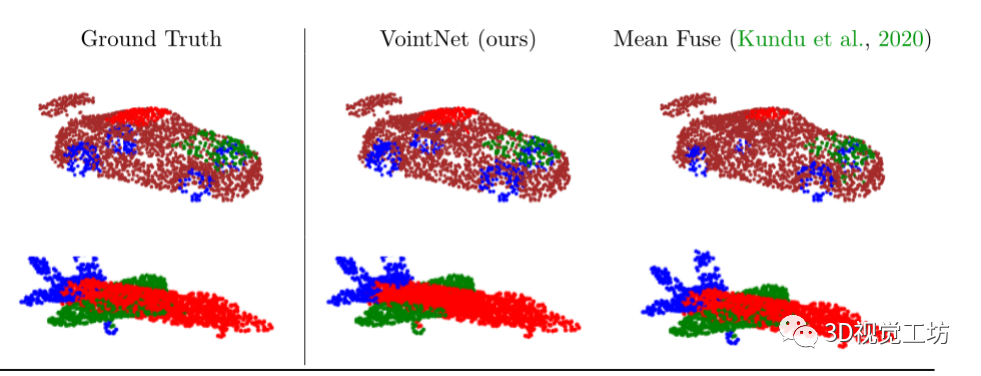

图 3:部件分割的定性比较。

- 将 VointNet 3D 分割预测与使用相同训练的 2D 主干的 Mean Fuse进行比较。

- 请注意 VointNet 如何区分细节部分(例如车窗框)。

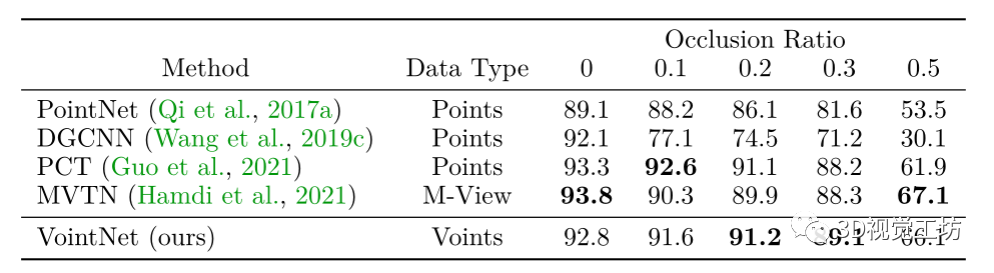

3D 形状检索表 5:3D 分类的遮挡稳健性。

报告了 ModelNet40上针对不同数据遮挡率的测试准确性,以衡量不同 3D 方法的遮挡稳健性。

表 3 在 ShapeNet Core55上对 3D 形状检索 mAP 进行了基准测试。

VointNet 在 ShapeNet Core55 上实现了最先进的性能。报告了基线结果。

稳健的 3D 部件分割表 4 报告了 VointNet 的实例平均分割 mIoU 与ShapeNet Parts 上的其他方法相比。报告了基准测试的两个变体:未旋转的归一化设置和旋转的真实设置。

- 对于旋转设置,遵循之前的 3D 文献通过在测试时(十次运行)随机旋转扰动 ShapeNet 部件中的形状来测试训练模型的稳健性,并在表 4 中报告平均值。

- 注意 VointNet ,在未旋转的设置上,尽管这两个基线使用与 VointNet 相同的经过训练的 2D 主干。

- 此外,对于旋转设置,点方法也不起作用。表 4 中的所有结果均由代码在同一设置中重现(请参阅补充材料中随附的代码)。

图 3 显示了 VointNet 和 Mean Fuse 的定性 3D 分割结果与ground truth相比。

Occlusion Robustness 遮挡稳健性最近研究的 3D 分类模型的稳健性方面之一是它们对遮挡的稳健性,如 MVTN 所述。这些模拟遮挡在测试时引入,并报告每个裁剪率的平均测试精度。

- 将 VointNet 与表 5 中的最新基线进行了基准测试。

- PointNet 和 DGCNN 被用作基于点的基线,MVTN 被用作多视图基线。

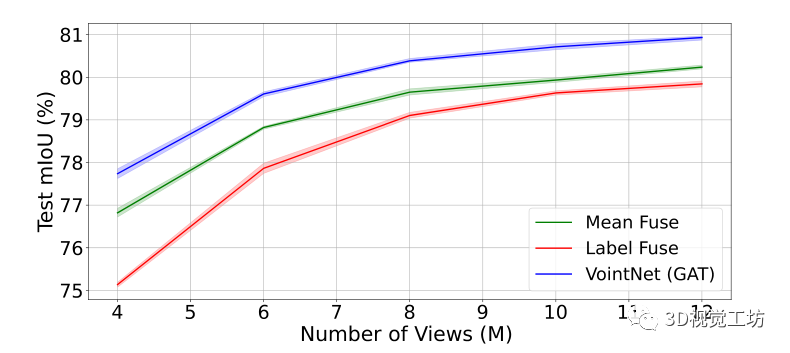

图 4:视图数量的影响。绘制 Ins。

- 3D 分割的mIoU 与 ShapeNet 部件推理中使用的视图数 (M)。

- 请注意 VointNet 对 Mean Fuse 和 Label Fuse的持续改进。

- 两个基线都使用与 VointNet 相同的经过训练的 2D 主干,并在相同的未旋转设置上进行测试。

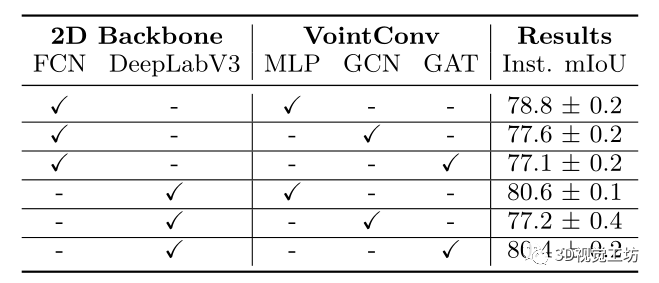

Analysis and Insights 分析和见解Number of Views 视图数量表 6:3D 分割的消融研究。

- 消融了 VointNet 的不同组件(2D 主干和VointConv 选择)并报告 Ins。

- mIoU 在 ShapeNetPart上的表现。

研究了视图数量 M 对使用多个视图的 3D 部件分割性能的影响。将 Mean Fuse 和 Label Fuse 与我们的VointNet 进行比较,因为它们都具有相同的训练的2D 主干。

- 视图是随机选择的,实验重复四次。具有置信区间的 mIoU 如图 4 所示。

- 观察到VointNet 在不同数量的视图中比其他两个基线有一致的改进。

消融了 2D 主干的选择和 VointNet 中使用的VointConv 操作,并报告了分割 Ins。表 6 中的 mIoU结果。

- 请注意 2D 主干如何极大地影响性能,而VointConv 操作类型不会。

- 这种消融突出了 2D 主干在 VointNet 中的重要性,并激发了 VointNet (MLP) 最简单变体的使用。

在附录中提供了更多因素以及计算和内存成本的详细研究。

Limitations and Acknowledgments 局限性和未来工作这项工作介绍了 Voint cloud表示,它继承了点云的优点和多视图投影的丰富视觉特征,导致增强的多视图聚合和在许多 3D 视觉任务上的强大性能。

- 限制 Voints 性能的一个方面是 2D 主干对下游 3D 任务的训练。在大多数情况下,必须使用足够的数据对 2D 主干进行预训练,以便为 VointNet 学习有意义的信息。

- 限制Voint-cloud 功能的另一个方面是如何正确选择用于分割的视点。满足于在训练时随机化视图。

解决这些局限性是未来工作的重要方向。此外,将Voint 学习扩展到更多 3D 任务(如 3D 场景分割和 3D对象检测)留给未来的工作。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。