接下来介绍基于部件的方法SegLink,它的核心思想是将文本行分解成两种可检测的元素:定义为部件(segment)和关联(link)。部件是指文本行的一部分(图中黄色部分),关联是指连接两个相邻部件的联系(图中绿色短线),被关联表明其属于同一单词或者文本行。 基于segments和links,整个文本行可以通过一个简单的组合表达出来。因为Segments和Links不涉及感受野问题,所以这个思路可以处理长文本行。

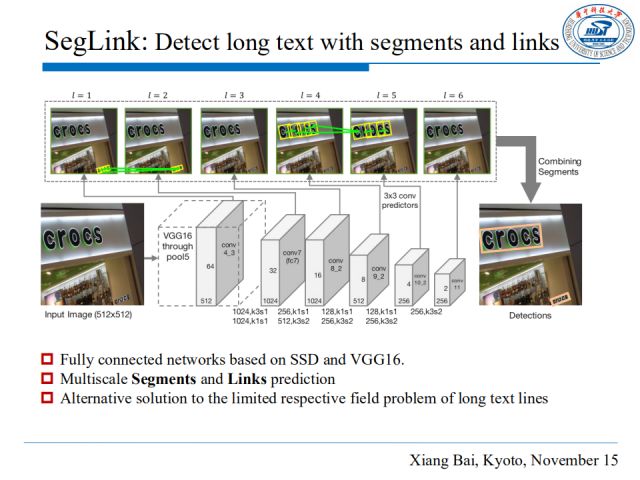

如图是SegLink的检测框架图,我们依旧使用SSD作为基础框架,采用VGG16检测模型,通过多层CNN同时检测segments和links,跨层连接是对不同层的两个segments的连接,它也是通过计算得到的,因为相邻的segments可能不会来自同一层。

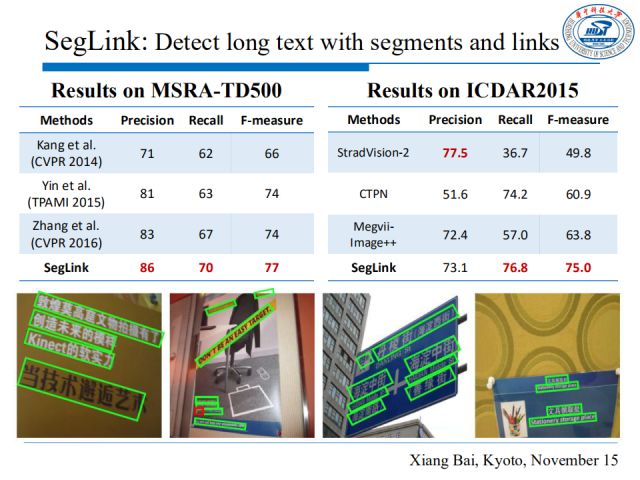

从在MSRA-TD500和ICDAR2015两个数据集上的测试结果来看,我们的SegLink方法对方向不确定的文本行和中英混合的文本都有较好的检测性能。

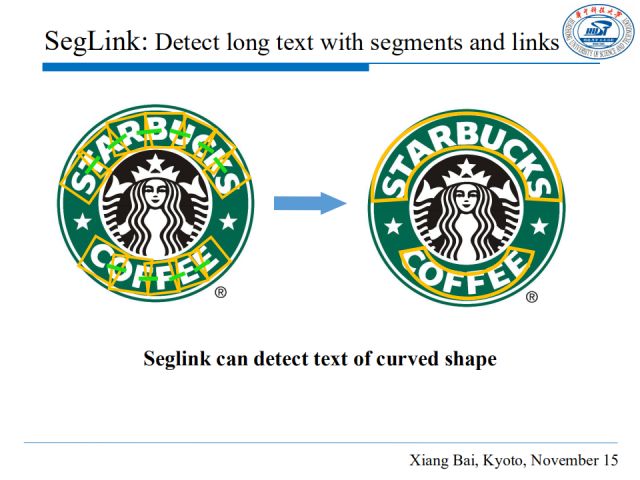

事实上,SegLink不仅能够处理长文本行,还可以很好地检测弯曲排列的文本行。如图,星巴克的logo字母是弯曲排列的,而SegLink可以灵活地适应它的文本形状。

场景文字识别

CRNN model

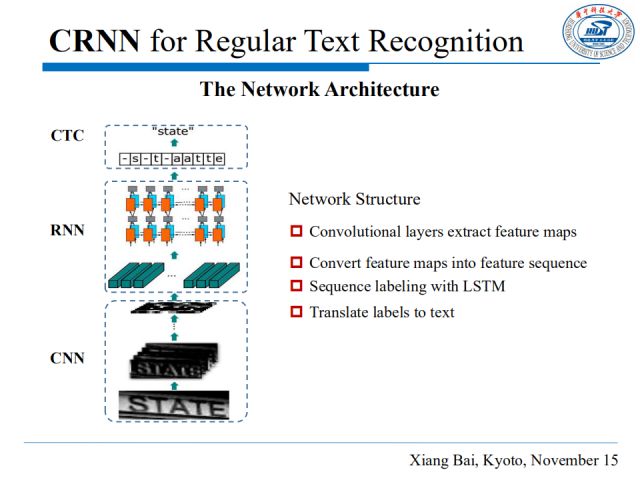

针对场景文字识别,这里主要讲述两个算法,针对整齐规则文本的CRNN模型,和针对不规则形文本的RARE模型。首先介绍CRNN:

该网络由三个部分组成:一个CNN网络,一个RNN网络和CTC损失。CNN(卷积神经网络)从输入图片提取特征,然后我们将图片特征转化为特征序列,作为序列标签输入到LSTM中,最后CTC(Connectionist temporal classification) loss将序列标签转化为文本。将这三个部分组合从而可以端到端地训练。

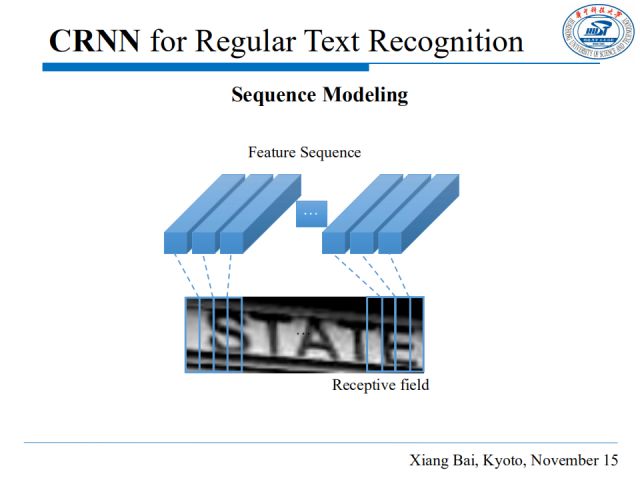

我们将每一个像素宽度图片的深度特征看作一帧,通过这种方法,可以从左到右获得一个帧序列,每一帧对应原始图像中的局部区域。

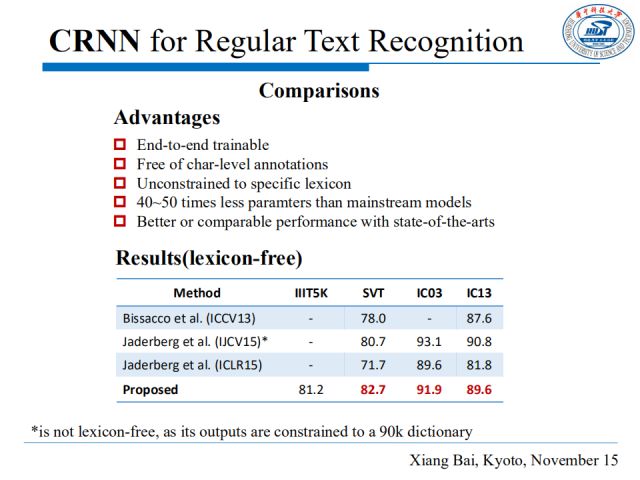

针对开放字典数据集,我们的方法在识别精度上达到了当时的state-of-the-arts。CRNN还具备以下优势:可以端到端训练;且不受字符标注的约束,这意味着我们可以直接输入文本行进行训练和测试;它没有字典集的限制,因此我们可以将其用于其他序列的识别,比如识别****上的数字;在模型大小上,它比主流的模型参数减少了40~50倍,更有利于在工业实际场景中落地。

RARE model

对于形状不规则的文本行,我们提出了RARE(Robust text recognizer with Automatic REctification)模型来解决。

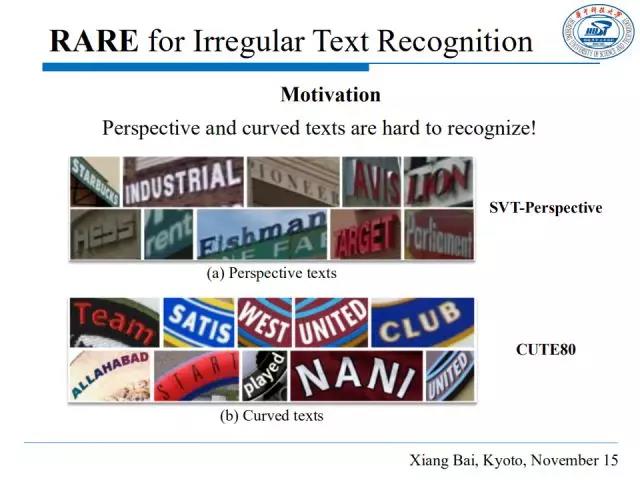

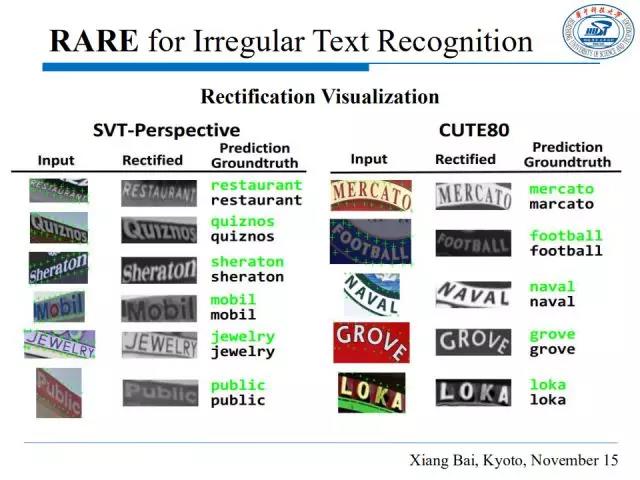

如图,由于拍摄视角的变化、文字曲形的排列方式等因素影响,自然场景图片中的文本形状常常是不规则的,如图中SVT-Perspective和CUTE80数据集所示,这就给识别造成了极大的困难。CRNN可能对此类情形并不奏效,它是在输入文本水平的前提下提出来的,因此我们提出了RARE。

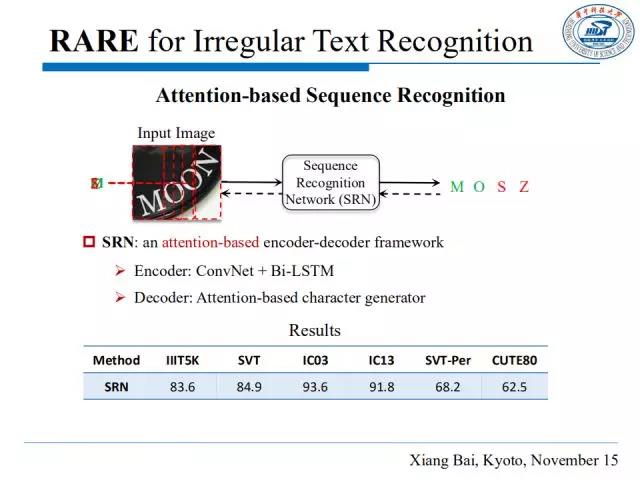

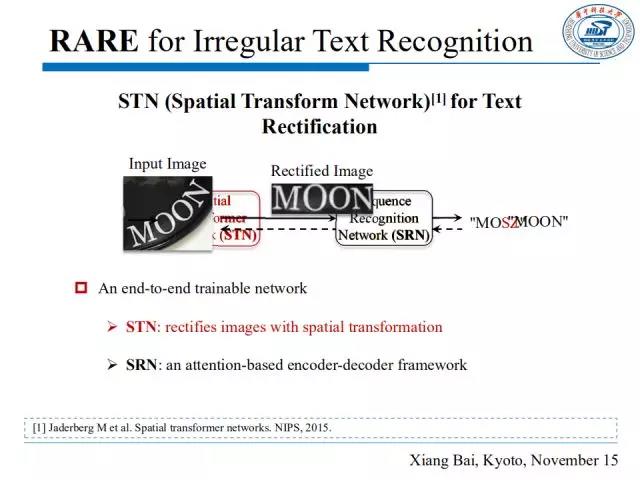

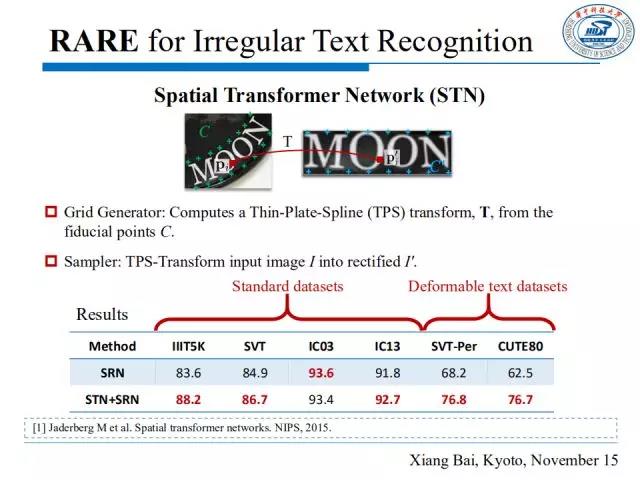

我们设计的网络由两部分组成,空间转换网络(STN, Spatial Transformer Network)和序列识别网络(Sequence Recognition Network)。其中,STN负责修正输入图片,使其图片中文本呈水平形,SRN负责识别文本。这两个网络通过反向传播进行联合训练,上图中的虚线就表示反向传播。

SRN包含一个编码器和一个****。编码器由一个ConvNet和一个Bi-LSTM组成,用来生成特征序列表达,****是一个基于注意力机制的字符生成器,根据输入序列循环地产生字符序列,根据每一步的注意力机制来解码相关内容,上图展示了SRN在各数据集上的识别精确度。

区别于CRNN模型中的****,我们使用基于注意力机制的模型作为RARE的****。****逐步将一些特征帧解码为一个字符,但由于某些帧中的形变,****可能会输出一些错误的识别结果。

在识别之前,我们可以引入一个空间变换网络STN(Spatial Transformer Network)来修正不规则文本图片。

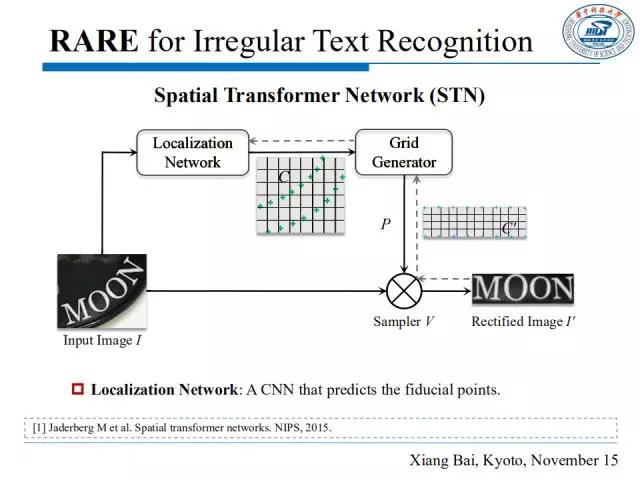

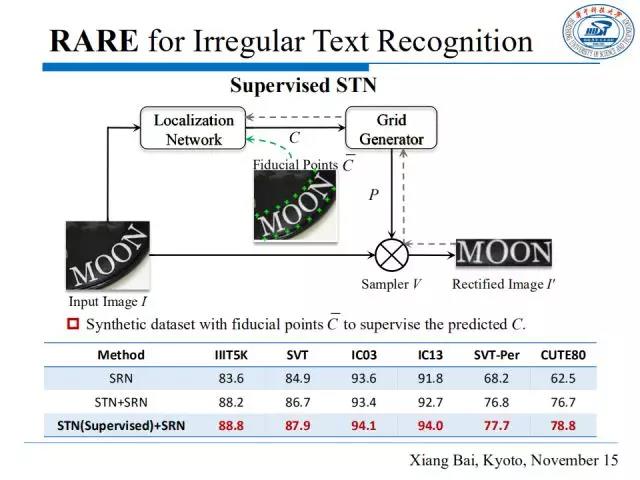

这里具体讲解一下STN的结构。首先定位网络生成一组基准点C,然后在网格生成器中,从基准点计算TPS变换的参数,在原图上生成一个采样网格P,采样器同时提取网格P和输入图片I,以此输出一个修正后的图片。

STN的一个特点是其采样器是可微的,因此只要有一个可微的定位网络和一个可微的网格生成器,STN就可以反向传播误差并得以训练。

网格生成器估计TPS变换的参数,并产生一个采样网格。如上图,原图中基准点是C,修正后图中定义基准点为C’,网格生成器计算TPS变换的参数T,采样器将原图I 修正为I’。上表显示,相比于单独使用SRN,添加STN可以大幅度提高识别效果,特别是对于一些有形变的文本数据集。

尽管STN校正有效地提高了识别率,但是对于严重弯曲的文本图片它的性能并不理想。因此,我们用带有边界点标注的文本数据作为定位网络的监督信息训练,实验表明,识别率有显著提升。

如图,是STN对SVT-Perspective和CUTE80两个数据集中有形变文本的修正结果。

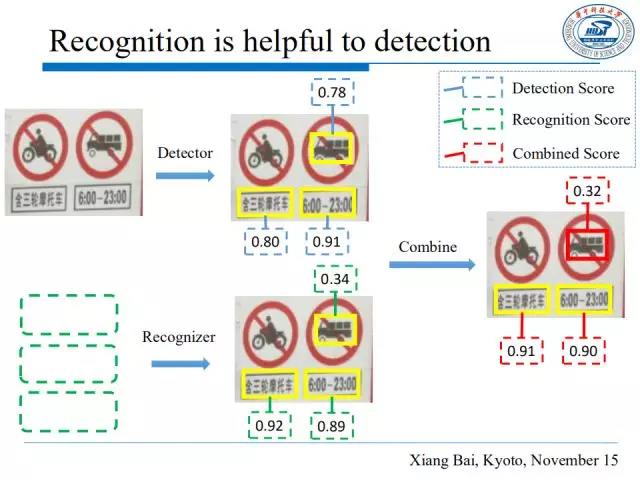

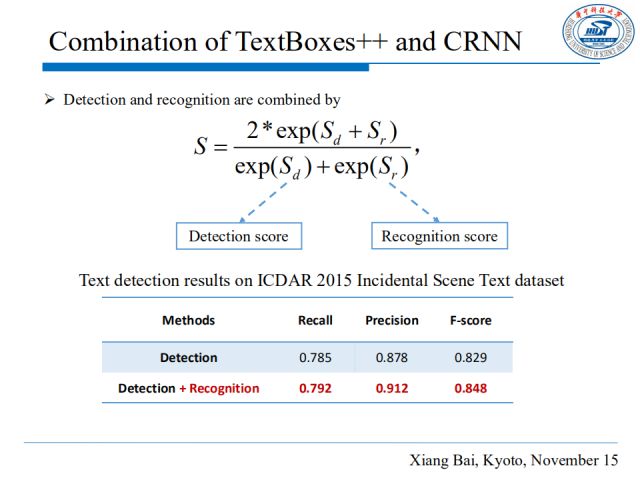

另一个有趣的发现是,将检测和识别结合起来,可以使得最终检测的准确率有极大提升。如图,输入图片通过检测器检测出来目标区域后,将检测的区域抠取出来输进识别器,这种组合使得很多误检可以被过滤掉,也就是说最终检测的性能提升了。

我们对检测得分和识别得分求取调和平均值,最终从ICDAR2015上的实验结果看出,这种组合有效提高了文本检测的效果。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。