MathWorks 宣布 MATLAB 与 NVIDIA TensorRT 集成来加快人工智能应用

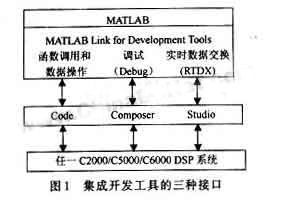

MathWorks 今日宣布 ,MATLAB现在可通过 GPU Coder 实现与 NVIDIA TensorRT 集成。这可以帮助工程师和科学家们在MATLAB中开发新的人工智能和深度学习模型,且可确保性能和效率满足数据中心、嵌入式应用和汽车应用不断增长的需求。

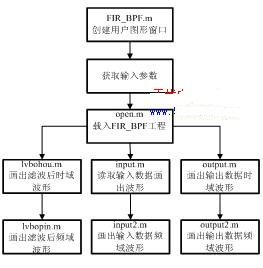

本文引用地址://m.amcfsurvey.com/article/201804/378263.htmMATLAB提供了一个完整的工作流程来快速训练、验证和部署深度学习模型。工程师可以使用 GPU 资源,而无需额外编程操作,因此可以专注于应用本身而不是性能调优。NVIDIA TensorRT 与 GPU Coder 的全新集成使得可以在 MATLAB 中开发深度学习模型,然后以高吞吐量低延迟的方式部署在 NVIDIA GPU 上运行。内部基准测试显示,MATLAB 生成的CUDA代码与 TensorRT 结合,在部署 Alexnet模型进行深度学习推理时,性能比 TensorFlow 高 5 倍;在部署 VGG-16 模型进行深度学习推理时,性能比 TensorFlow 高 1.25 倍。*

“不断发展的图像、语音、传感器和物联网 (IoT) 技术促使团队以更好的性能和效率研究人工智能解决方案。此外,深度学习模型变得越来越复杂。所有这些都给工程师们带来了巨大的压力,” MathWorks 总监 David Rich 说。“现在,团队可以使用 MATLAB 训练深度学习模型,NVIDIA GPU 可以将实时推理部署到从云端到数据中心到嵌入式边界设备等各种环境中。”

评论