清华大学在支持片上学习的忆阻器存算一体芯片领域取得重大突破

当前,生成式人工智能已引爆新一轮智能革命的发展浪潮,大算力支撑下的人工智能技术极大改变着人类的生产生活方式。可随之而来的海量参数令算力需求持续攀升,如何解决庞大的算力缺口,实现能效比的大幅提升,正在变得日益迫切。高算力、高能效芯片作为算力的具体载体,已成为驱动本轮智能革命发展的核心底座,更是推动人类社会不断发展的动力源泉。

本文引用地址://m.amcfsurvey.com/article/202309/450640.htm面向传统存算分离架构制约算力提升的重大挑战,集成电路学院吴华强教授、高滨副教授聚焦忆阻器存算一体技术研究,探索实现计算机系统新范式。忆阻器存算一体技术从底层器件、电路架构和计算理论全面颠覆了冯·诺依曼传统计算架构,可实现算力和能效的跨越式提升,同时,该技术还可利用底层器件的学习特性,支持实时片上学习,赋能基于本地学习的边缘训练新场景。当前国际上的相关研究主要集中在忆阻器阵列层面的学习功能演示,然而实现全系统集成的、支持高效片上学习的忆阻器芯片仍面临较大挑战,至今还未实现,主要在于传统的反向传播训练算法所要求的高精度权重更新方式与忆阻器实际特性的适配性较差。

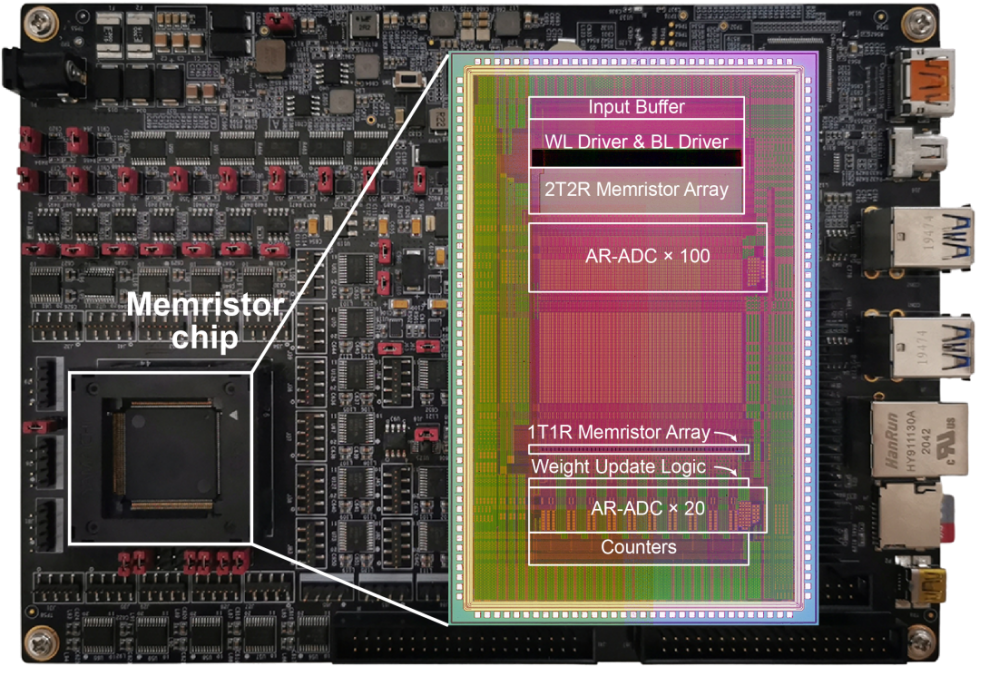

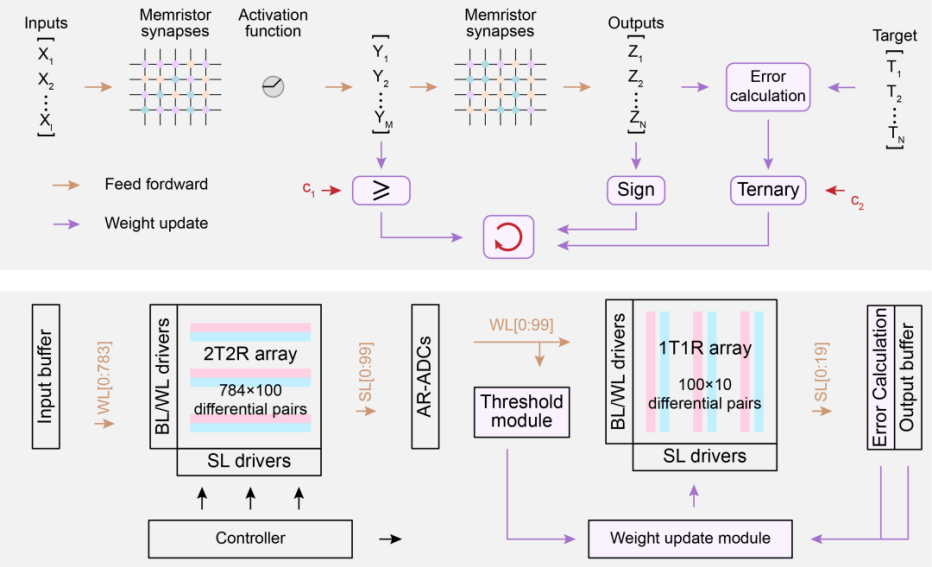

为解决上述难题,课题组基于存算一体计算范式,创造性提出适配忆阻器存算一体实现高效片上学习的新型通用算法和架构(STELLAR),有效实现大规模模拟型忆阻器阵列与 CMOS 的单片三维集成,通过算法、架构、集成方式的全流程协同创新,研制出全球首颗全系统集成的、支持高效片上学习的忆阻器存算一体芯片。该芯片包含支持完整片上学习所必需的全部电路模块,成功完成图像分类、语音识别和控制任务等多种片上增量学习功能验证,展示出高适应性、高能效、高通用性、高准确率等特点,有效强化了智能设备在实际应用场景下的学习适应能力。相同任务下,该芯片实现片上学习的能耗仅为先进工艺下专用集成电路(ASIC)系统的 3%,展现出卓越的能效优势,极具满足人工智能时代高算力需求的应用潜力,为突破冯·诺依曼传统计算架构下的能效瓶颈提供了一种创新发展路径。

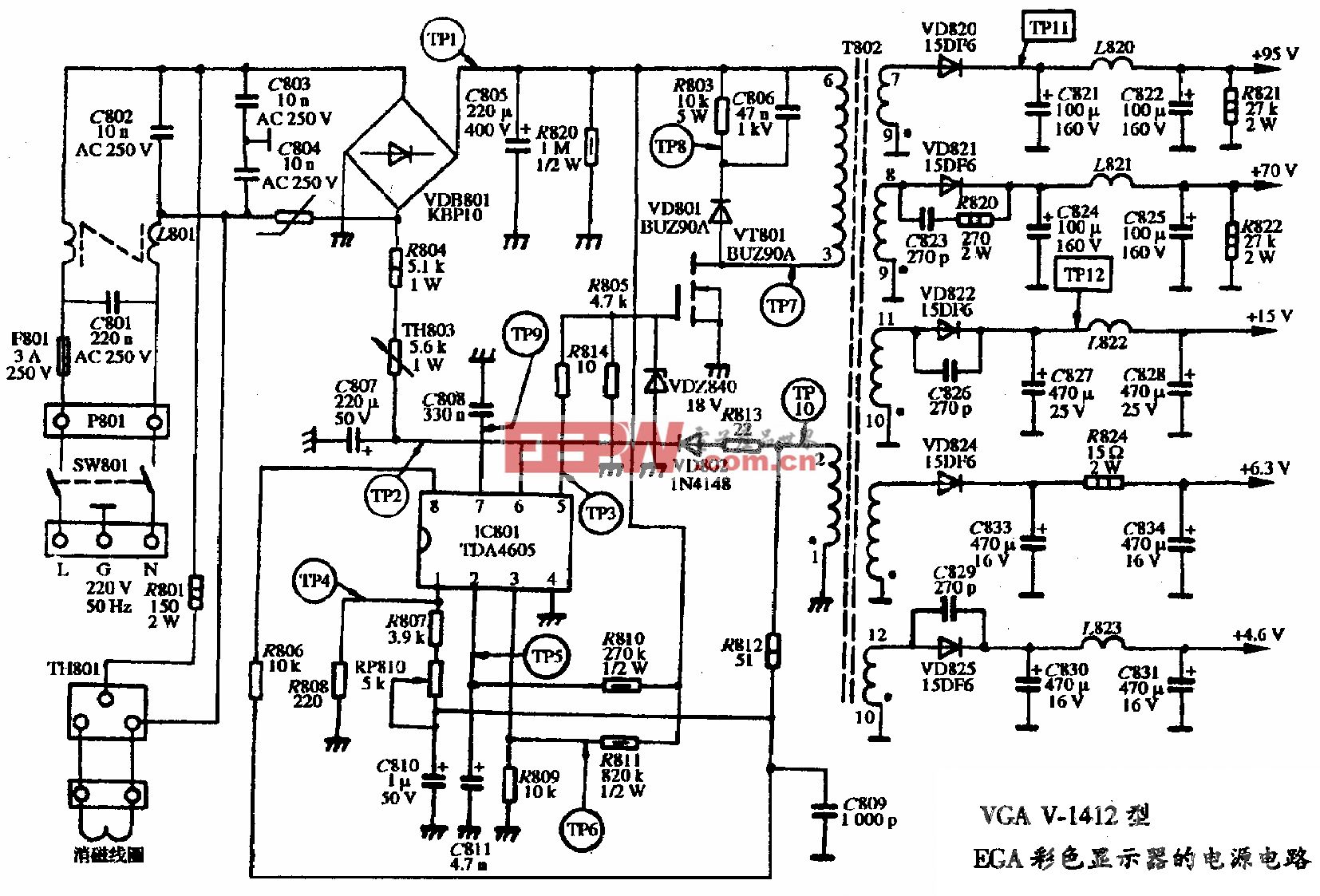

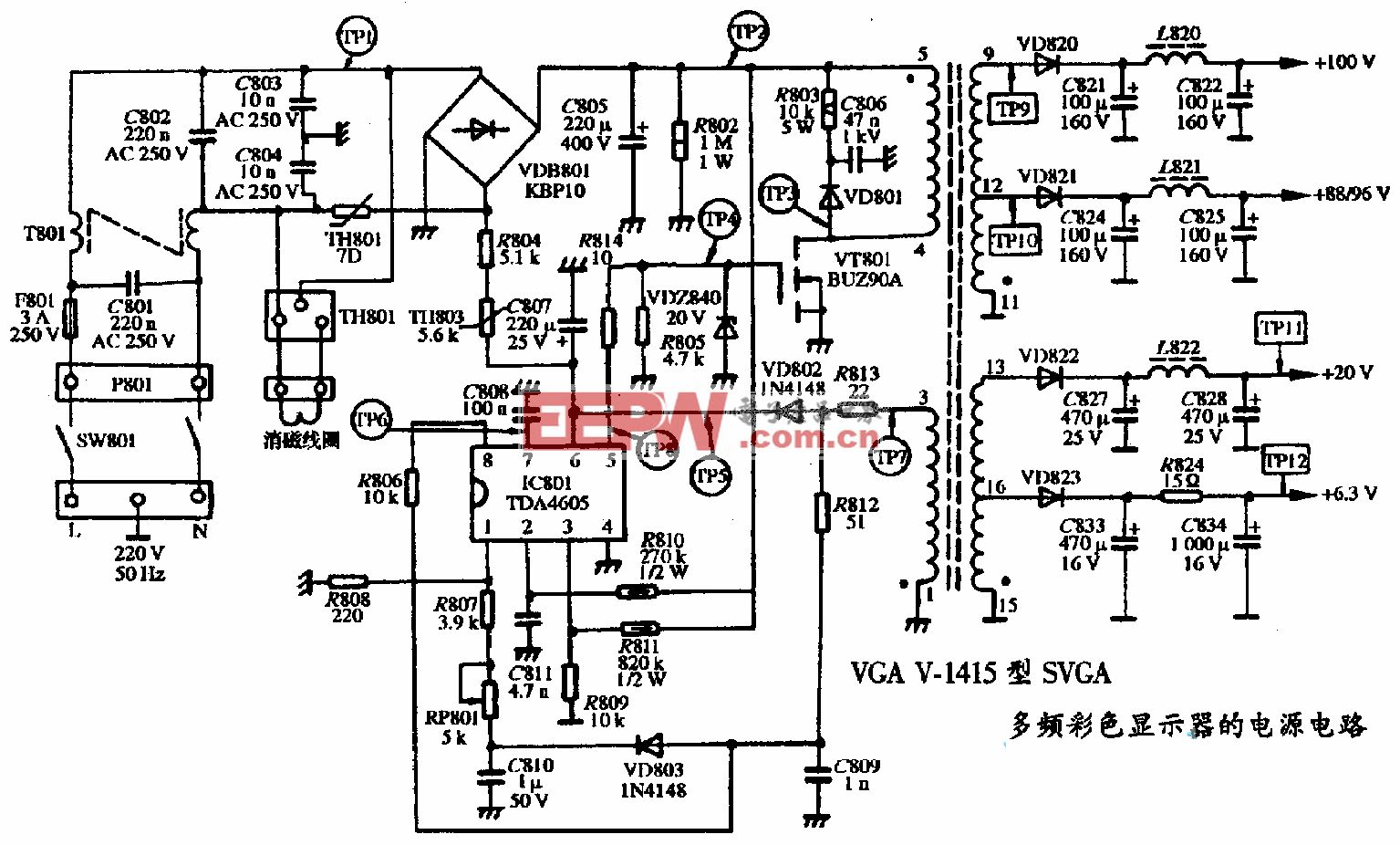

图一:忆阻器存算一体芯片及测试系统

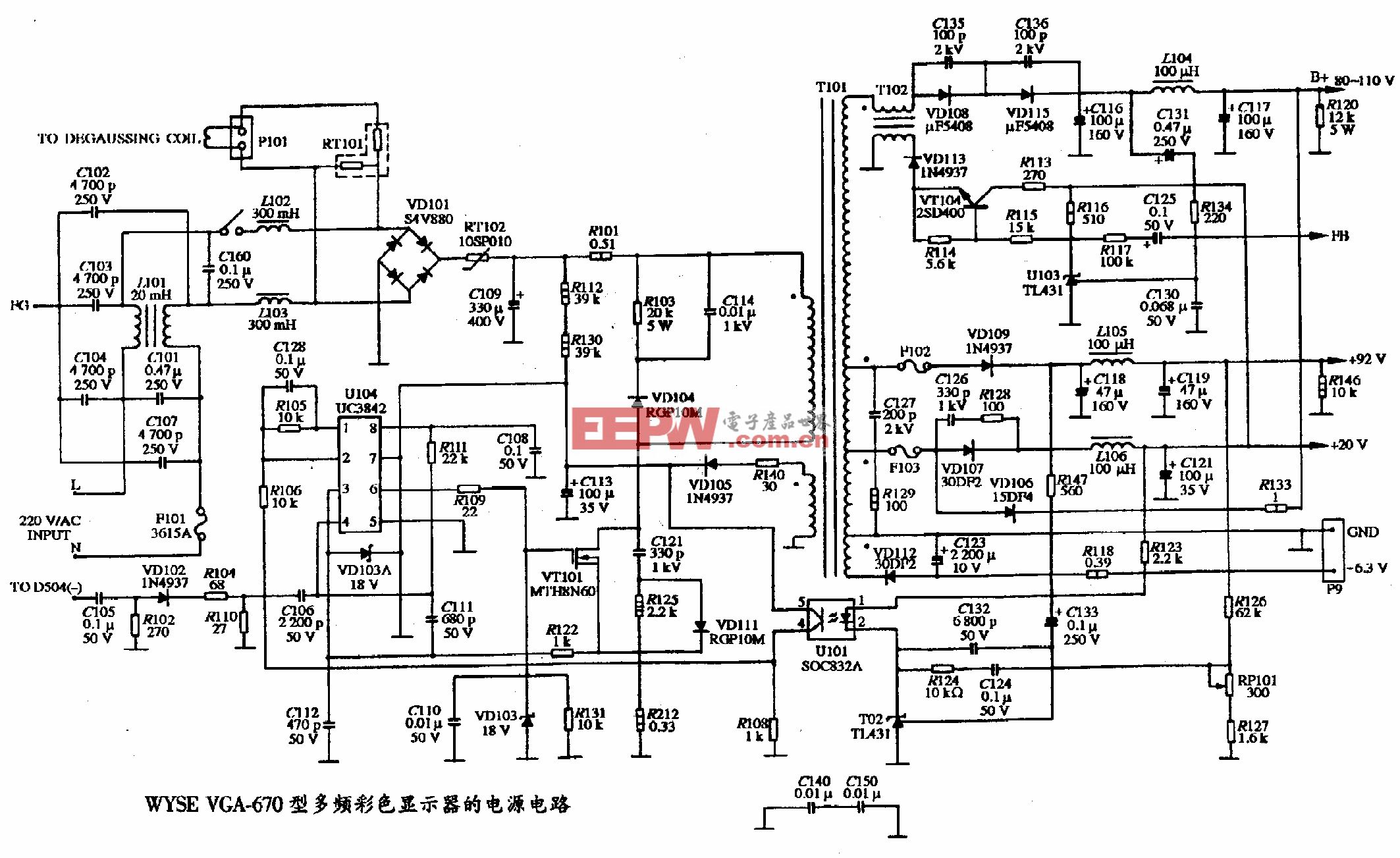

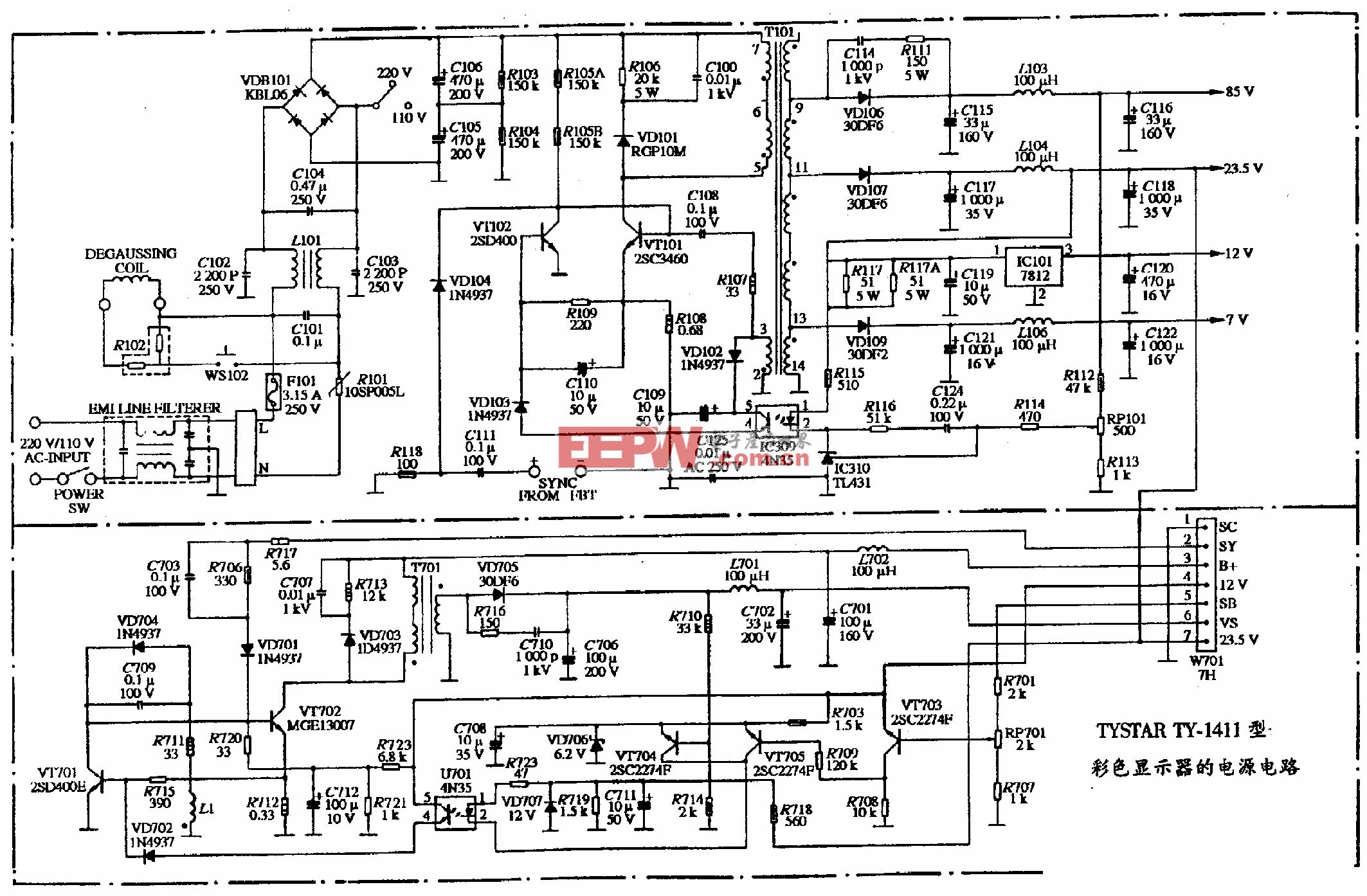

图二:基于忆阻器存算一体, 实现高效片上学习的通用算法和架构

该研究成果以「面向边缘学习的全集成类脑忆阻器芯片」(Edge Learning Using a Fully Integrated Neuro-Inspired Memristor Chip)为题在线发表在《科学》(Science)上。

论文通讯作者为清华大学集成电路学院高滨副教授和吴华强教授,清华大学集成电路学院博士生张文彬、博士后姚鹏为论文的共同第一作者,其他参加研究的作者包括清华大学集成电路学院钱鹤教授、唐建石副教授、伍冬副研究员、张清天助理研究员,清华大学电子系汪玉教授等。

该研究得到科技部科技创新 2030「脑科学与类脑研究」重大项目、国家自然科学基金委后摩尔重大研究计划、北京集成电路高精尖创新中心等支持。

论文链接

https://www.science.org/doi/full/10.1126/science.ade3483

清华大学集成电路学院钱鹤、吴华强教授团队长期致力于基于忆阻器的存算一体技术研究,从器件制备、工艺集成、电路设计及架构与算法优化等多层次实现创新突破,先后在《自然》(Nature)、《科学》(Science)、《自然·纳米技术》(Nature Nanotechnology)、《自然·电子》(Nature Electronics)、《自然·机器智能》(Nature Machine Intelligence)等顶级期刊以及国际电子器件会议(IEDM)、国际固态半导体电路大会(ISSCC)等领域内顶级国际学术会议上发表多篇论文。高滨课题组作为团队重要研究力量,长期从事忆阻器性能优化和存算一体芯片设计方法的相关研究,成功开发了从器件到系统的联合仿真工具和协同优化方法,设计出计算精度大于 95%、能效大于 78TOPs/W 的高性能忆阻器存算一体芯片。

什么是存算一体?

存算一体(Computing in Memory)是在存储器中嵌入计算能力,以新的运算架构进行二维和三维矩阵乘法/加法运算。

存算一体技术概念的形成,最早可以追溯到上个世纪 70 年代。随着近几年云计算和人工智能(AI)应用的发展,面对计算中心的数据洪流,数据搬运慢、搬运能耗大等问题成为了计算的关键瓶颈。

在过去二十年,处理器性能以每年大约 55% 的速度提升,内存性能的提升速度每年只有 10% 左右。结果长期下来,不均衡的发展速度造成了当前的存储速度严重滞后于处理器的计算速度。

在传统计算机的设定里,存储模块是为计算服务的,因此设计上会考虑存储与计算的分离与优先级。但是如今,存储和计算不得不整体考虑,以最佳的配合方式为数据采集、传输和处理服务。这里面,存储与计算的再分配过程就会面临各种问题,而它们主要体现为存储墙、带宽墙和功耗墙问题。

虽然多核(例如 CPU)/众核(例如 GPU)并行加速技术也能提升算力,但在后摩尔时代,存储带宽制约了计算系统的有效带宽,芯片算力增长步履维艰。

从处理单元外的存储器提取数据,搬运时间往往是运算时间的成百上千倍,整个过程的无用能耗大概在 60%-90% 之间,能效非常低,「存储墙」成为了数据计算应用的一大障碍。特别是,深度学习加速的最大挑战就是数据在计算单元和存储单元之间频繁的移动。

存内计算和存内逻辑,即存算一体技术直接利用存储器进行数据处理或计算,从而把数据存储与计算融合在同一个芯片的同一片区之中,可以彻底消除冯诺依曼计算架构瓶颈,特别适用于深度学习神经网络这种大数据量大规模并行的应用场景。

存算一体发展史

1969 年,斯坦福研究所的 Kautz 等人提出了存算一体计算机的概念。但受限于当时的芯片制造技术和算力需求的匮乏,那时存算一体仅仅停留在理论研究阶段,并未得到实际应用。

为了打破冯诺依曼计算架构瓶颈,降低「存储-内存-处理单元」过程数据搬移带来的开销,学术界和工业界尝试了多种方法。其中比较直接的方法是近存计算,减少内存和处理单元之间的路径,如通过 3D 封装技术实现 3D 堆叠,将多层 DRAM 堆叠而成的新型内存,能提供更大的内存容量和内存带宽。此外,Intel 和 Micron 合作开发的基于 PRAM 存储介质的 3D Xpoint 属于堆叠型内存,旨在缩短片上存储与内存之间的路径。但上述方案并没有改变数据存储与数据处理分离的问题,并不能从根本上解决冯诺依曼计算架构瓶颈。

近年来,随着半导体制造技术的突飞猛进,以及 AI、元宇宙等算力密集的应用场景的崛起,为存算一体技术提供新的制造平台和产业驱动力。

2010 年,惠普实验室的 Williams 教授团队用忆阻器实现简单布尔逻辑功能。2016 年,美国加州大学圣塔芭芭拉分校(UCSB)的谢源教授团队提出使用 RRAM 构建存算一体架构的深度学习神经网络 (PRIME)。相较于传统冯诺伊曼架构的传统方案,PRIME 可以实现功耗降低约 20 倍、速度提升约 50 倍,引起产业界广泛关注。

随着人工智能等大数据应用的兴起,存算一体技术得到国内外学术界与产业界的广泛研究与应用。在 2017 年微处理器顶级年会 (Micro 2017) 上,包括英伟达、英特尔、微软、三星、加州大学圣塔芭芭拉分校等都推出了他们的存算一体系统原型。

评论