行业大牛开启新征程,芯片架构创新迎来新局面

本周,全球 IT 业最大的新闻非 OpenAI 联合创始人山姆·奥特曼(Sam Altman)离开原公司、加入微软莫属。当然,这并不是终点。

本文引用地址://m.amcfsurvey.com/article/202312/453557.htmSam Altman 被 OpenAI 董事会驱逐,被认为是技术派的胜利,因为另一名联合创始人萨斯克维尔认为 Altman 商业化行动过于激进,存在很多安全隐患,因此,联合其他三名外部董事驱逐了 Altman。

本文不关注 OpenAI 的「宫斗」大戏,无论 Altman 最终留在微软,还是回归 OpenAI,都不会影响他开创 AI 软硬件新技术和市场的意愿,区别只是在哪里做而已。

据悉,在被解职之前,Altman 就在探寻新业务,曾试图在中东筹集数十亿美元用于人工智能(AI)芯片项目 Tigris,还想创建一家专注于 AI 芯片研发的公司,或许,这一项目已经被微软拿下了。另外,Altman 还一直在寻求为一款 AI 硬件设备筹集资金,该设备是他与前苹果设计总监 Jony Ive 共同开发的。

近些年,在 AI 发展方兴未艾的大背景下,不甘于已经取得的「辉煌成绩」,选择开创新业务(从新创业或加盟一家富有活力的大公司)的行业大牛不止 Altman 一人,还有多位业界知名业界人士,特别是技术大牛,都选择了再创业,因为他们无法抵挡 AI 发展的巨大潜力,要趁当下还处于「野蛮成长」的产业发展初级阶段,争取用先进的技术和产品,掌控未来竞争的主动权。在这些人当中,典型代表是 CPU 架构大神 Jim Keller 和GPU架构大神 Raja Koduri。

2020 年 6 月,Jim Keller 离开了工作两年的英特尔,2021 年初,AI 芯片初创公司 Tenstorrent 宣布任命 Jim Keller 为公司总裁兼首席技术官,以及董事会成员。Tenstorrent 创立于 2016 年,旨在通过一种新方法和体系结构,研发新型 AI 处理器,以推动 AI 和机器学习的发展。近两年,Tenstorrent 十分看重 RISC-V 的应用前景,认为其非常适合未来低功耗 AI 应用市场需求。

2023 年 3 月,Raja Koduri 离开了工作五年的英特尔,选择创业。据 Koduri 透露,他的新创公司 Mihira AI 要打造新的生成式人工智能工具,这些工具可以在英特尔、AMD、苹果等公司的芯片上运行,也可以在未来的 RISC-V 架构芯片上运行。

AI 系统和芯片需要改进

当下的 AI 服务器,多采用异构形式搭建,也就是在计算系统中,使用多种不同类型的处理器(CPU、GPU、FPGA、NPU 等),这样可以增加计算速度和效率,以满足不同工作负载的需求,因为 AI 工作负载通常需要大量的数值计算和并行运算。

传统 CPU 在通用计算方面表现出色,但对于深度学习等需要大量矩阵计算的任务,效能就会不足,这时,将GPU、TPU 等处理器组合其中,可以更好地满足 AI 任务的需求,提供更高效的运算能力。

对于 AI 系统的这种异构需求,不同处理器厂商,特别是像 AMD 和英伟达这样的传统大厂,以及自研 AI 芯片的互联网大厂,都有各自的解决方案,但不同方案虽然有各自优势,但也存在这样或那样的缺点。

AMD 公司推出了APU概念和产品,它就是 CPU +GPU 的组合,其优点是可以充分发挥两种处理器各自的优势,互相弥补短板,也能在一定程度上减少功耗。不过,其 AI 训练性能并不比独立的 GPU 好。

为了满足自家系统的需求,Google 自研了张量处理器 TPU(Tensor Processing Unit),它是一种 ASIC 处理器,与 CPU、GPU 和APU等通用处理器有很大区别,TPU 的专用性很强,针对机器学习和深度学习等 AI 应用进行了优化,专门用于加速 AI 的计算任务。不过,在 Google 的整个网络系统当中,依然需要用到大量的通用 CPU 和 GPU,TPU 虽然很好用,但可用规模还是有限的。

可见,要不断改善 AI 服务器系统性能,单一的通用或专用处理器都无法独自解决问题,需要多种处理器配合工作才行,这就给新的 AI 芯片技术和产品发展提供了机会。

AI 系统的训练和推理平衡水平需要改善。

目前,英伟达的 GPU 是 AI 训练芯片市场的领导者,但这只占整个 AI 芯片需求的 20% 左右,推理芯片市场相当大,当下的 GPU 擅长 AI 训练,而 CPU 擅长推理,二者在对方领域的局限性都很大。

在 AI 推理市场,除了数据中心和云计算,用户对边缘侧(如手机、PC,以及机器人、工业系统和汽车等)的推理需求在快速增长。因此,AI 推理市场不仅很大,而且相当分散。在这种情况下,边缘侧 AI 推理芯片的市场规模非常大,而且具有极大的发展潜力。

苹果公司的 iPhone 就是一个典型的例子,它在 A 系列处理器中集成了 AI 内核,目前,AI 功能已经占据了 A 系列处理器整体功能的 20%。近些年,多家公司也在采用类似于苹果的 SoC AI 策略。

粗略计算,AI 芯片市场包括约 15% 的训练,45% 的数据中心推理,以及 40% 的边缘侧推理。在这样的市场背景下,一方面,各大处理器厂商正在提升 AI 训练和推理能力的融合水平,另一方面,边缘侧推理市场的巨大发展空间给很多移动处理器厂商提供了拓展机会。

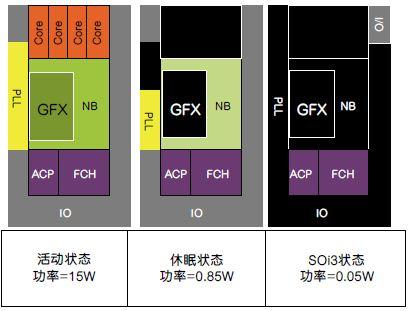

AI 系统和芯片的功耗也需要改善。

如上文所述,边缘侧推理市场巨大,而这些应用对低功耗要求很高。同时,数据中心和云计算系统的功耗高的吓人,不可能无止境地增加下去,解决这一大应用领域的功耗问题也被越来越多的芯片和系统厂商所重视。

问题如何解决?

从上文介绍中可以看出,AI 系统和相关芯片还处于成长期,有很多问题需要解决,特别是 AI 训练和推理芯片的功能融合、边缘侧 AI 推理,以及功耗问题,是各大厂商,以及初创企业共同关注的。

最近,英伟达推出的新 GPU 在 AI 训练和推理融合能力方面就有很大进步,该公司表示,H100 芯片的升级产品 H200 集成了 141GB 的 HBM3e 内存,更加擅长推理,在用于推理或生成问题答案时,性能较 H100 提高了 60%-90%。英伟达表示,与 H100 相比,H200 在 Llama 2 这样拥有 700 亿参数大语言模型上的推理速度提升了近一倍。

在边缘侧推理方面,以苹果为学习对象,传统手机处理器厂商也在增加新产品的 AI 推理能力。以联发科为例,该公司推出的天玑 8300 可支持生成式 AI,最高支持 100 亿参数 AI 大语言模型。该芯片集成了生成式 AI 引擎,整数运算和浮点运算的性能是上一代的两倍,支持 Transformer 算子加速和混合精度 INT4 量化技术,AI 综合性能是上一代的 3.3 倍,可流畅运行终端侧生成式 AI 的各种新应用。

在降低 AI 服务器功耗方面,初创企业和各大知名厂商投入的力度更大。

以上文提到的 Jim Keller 加入的 Tenstorrent 为例,该公司正在开发数据中心解决方案,核心产品是基于 RISC-V 架构的 AI/ML 加速器和通用处理器。之所以采用 RISC-V 指令集,很重要的一个原因就是其功耗低。

据悉,Tenstorrent 正在与日本新创晶圆厂 Rapidus 合作,开发基于 2nm 制程工艺的边缘侧 AI 处理器及相关 IP。从目前的 AI 系统市场需求,以及未来该领域对低功耗(数据中心、云和边缘侧都要求降低功耗)的要求来看,先进制程的未来发展前景依然值得期待,因为 3nm、2nm,甚至是 1nm 这样的先进制程技术,就是要在不断提升性能的同时,持续降低功耗。未来,先进制程工艺几乎就是为 AI 芯片而生的。

对于开发 RISC-V 芯片和系统,半导体大国政府都很重视。美国政府已经下达了使用 RISC-V 处理器来模拟下一代稀疏性超级计算机的指示,欧盟也建立了一个基于 RISC-V 架构的本土加速器项目,称为 EPAC。

除了新创企业,传统大厂也在发展低功耗 AI 芯片方面不遗余力。

以微软为例,该公司于近期推出了用于云端软件服务的处理器 Cobalt,该芯片是基于 Arm 架构的通用处理器,同时,微软还推出了另一款专用 AI 加速器 Maia 100,用于云端训练和推理。这两款芯片将于 2024 年导入该公司的 Azure 数据中心。微软基于 Arm 架构研发芯片,很重要的一个原因就是其功耗比较低。

除了将 AI 训练和推理融合,以及低功耗之外,现有架构芯片,特别是 CPU、GPU,在 AI 计算方面都存在局限性,因此,一些初创公司,以及传统知名厂商还在探索新型架构的 AI 芯片,特别是在打破处理单元与内存之间的「通信墙「方面,下了很多功夫。

近些年,以 Groq、Cerebras、SambaNova、NextSilicon 等为代表的创业公司都在开发各自的新型 AI 加速器,目标是替代英伟达的 GPU。这些公司的产品多为 ASIC,也就是 AI 专用处理器,目前来看,这些新型处理器正在被美国能源部实验室所采用,用于科学研究。同时,美国多家大学也对试用这些芯片持开放态度,例如,NCSA 正在与 SambaNova 合作开发芯片,Cerebras 的处理器已经用于 AI 训练。

在创新架构处理器研发方面,大厂 IBM 一直都是业界的典型代表,AI 专用芯片方面同样如此。最近,IBM 推出了一种新的原型芯片架构 NorthPole,可以使 AI 计算更快、更节能。NorthPole 是一款基于人脑计算通路进行神经推理的数字 AI 芯片,它采用了一种截然不同的设计方法,将所有内存都集成在了处理器芯片上,无需外挂 RAM,这使得该处理器能够进行快速的 AI 推理。该芯片专为 AI 推理而设计,不需要复杂的冷却系统。据悉,小巧灵活的 NorthPole 非常适合边缘侧 AI 应用。

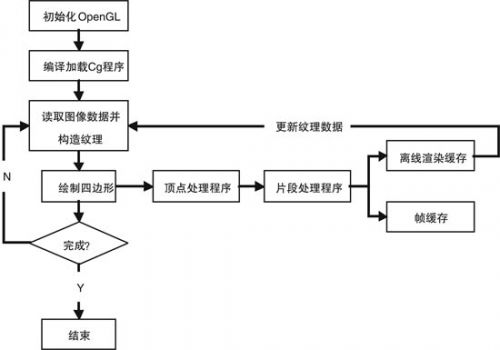

以上介绍的都是各种 AI 处理器,是硬件。要使整个 AI 系统充分发挥效能,软件工具的作用也很重要。如前文所述,GPU 架构大神 Raja Koduri 离开英特尔后,创建了新公司 Mihira AI,该公司研发的就是 AI 软件工具。

据 Koduri 介绍,Mihira AI 的最底层是一个异构数据中心架构,涵盖三类工作负载,分别是:用于渲染通用 CPU 计算;用于 AI 的异构加速器;用于游戏 GPU 工作负载。他说,未来的第四个集群可以针对低功耗 AI 推理进行优化。

从未来发展来看,Mihira AI 的目标很可能是替代英伟达的 CUDA,以及 AMD 的 ROCm 软件生态系统。不过,目前它还处于发展初期,未来的道路十分艰辛。

结语

AI 系统、芯片和软件市场发展潜力巨大,各种传统和创新产品同台竞争,随着应用和市场的发展,未来具有很大的想象和操作空间。

正是看到了各种 AI 技术、产品和商业的发展可能性,越来越多的行业大牛依托创业公司,或依托各大知名厂商,开始了各种创新工作。

在本文截稿时,报道称 Sam Altman 又回到了 OpenAI,继续担任 CEO。经过这一波操作,Altman 有望在 OpenAI 获得更多的施展空间,其 AI 技术和商业拓展之路很可能会加速。

评论