2024 年,GPU 能降价吗?

2023 过去,当我们回顾这一年的最受产业关注的芯片,相信大多数人会将票投向GPU。2023 年中,我们总能听到「GPU紧缺」、「英伟达狂飙」、「黄仁勋分享成功秘诀」。

本文引用地址://m.amcfsurvey.com/article/202401/454904.htm无可否认,2023 年生成式 AI 的热潮无边无际,全球高科技公司都涌入了 AI 的军备竞赛。随之带来的是算力告急、全球疯抢GPU。

全球最火的 GPU

2023 年层出不穷地传出,人工智能 AI 大模型的消息。OpenAI、百度、谷歌、腾讯都在搭建属于自己的大模型。对于这些五花八门的大模型,我们不多赘述,但大模型的搭建,最需要的就是 GPU,而 2023 年需求量最大的 GPU 不外乎:A100/H100。

首当其冲的就是 A100GPU。OpenAI 使用的是 3,617 台 HGXA100 服务器,包含近 3 万块英伟达 GPU。国内云计算相关专家认为,做好 AI 大模型的算力最低门槛是 1 万枚英伟达 A100 芯片。

TrendForce 研究则显示,以 A100 的算力为基础,GPT-3.5 大模型需要高达 2 万枚 GPU,未来商业化后可能需要超过 3 万枚。

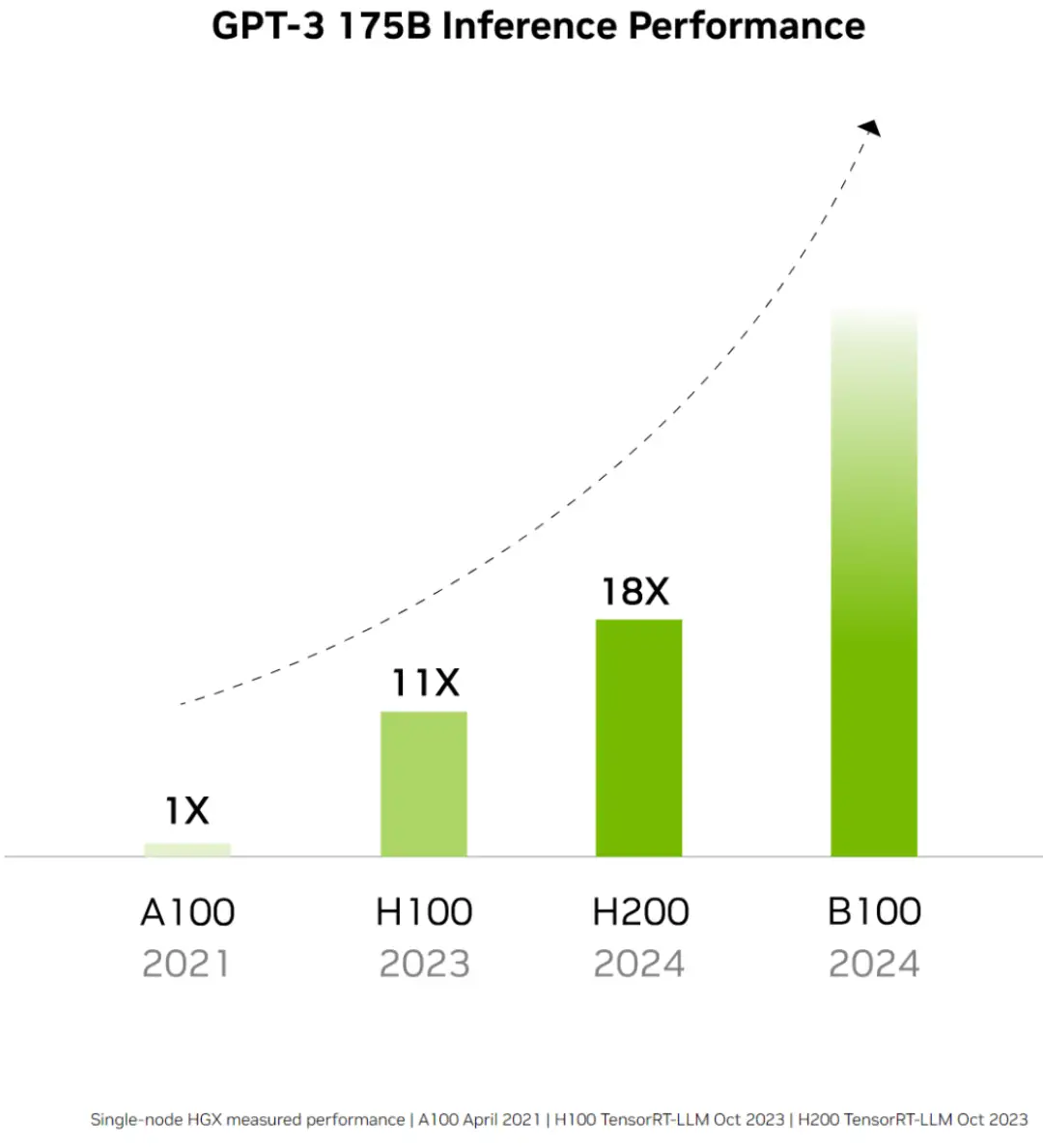

H100 也是业内追求的对象。H100 于去年 9 月量产,由台积电 4N 工艺代工。相较于前任 A100,H100 单卡在推理速度上提升 3.5 倍,在训练速度上提升 2.3 倍;如果用服务器集群运算的方式,训练速度更是能提高到 9 倍,原本一个星期的工作量,现在只需要 20 个小时。

考虑到整体系统成本,H100 每美元产生的性能比 A100 还要高 4 到 5 倍之多。与 A100 相比,H100 的单卡价格更贵,但是由于其训练、推理效率增加,成为了最具性价比的产品。

正因如此,科技大厂各个都抢着要买英伟达 H100GPU,或者更准确地说,是英伟达的 8-GPU HGX H100SXM 服务器。

英伟达成为了最受关注的卖铲人。针对中国市场,还按照 A800 操作模式(A100 芯片的降维版本),推出了完全符合出口规定的 H100 的降维版本芯片。

热情的买家

「GPU 就是新时代的比特币。」OpenAI 首席科学家 IlyaSutskever 将这句话写在他个人的 X 账号上。在算力激增的背景下,英伟达的 GPU 成为了「硬通货」。

夸张的是,甚至有海外初创企业开始利用 GPU 进行抵押融资,一家硅谷的创业公司使用 H100 拿到了 23 亿美元的债务融资。

购买 H100 和 A100 的公司有三种。第一种,是需要超过 1000 张的公司,包括训练 LLM 的创业公司,如 OpenAI、Anthropic;云服务提供商,如谷歌云、AWS、腾讯云;其他大公司,如特斯拉。第二种,是需要超过 100 张的公司,也就是对开源模型进行大量微调的初创公司。第三种,需要 10 张的公司,就是大部分创业公司和开源势力,热衷使用大模型的输出微调小模型。

这些买家需要多少 GPU 呢?OpenAI 可能需要 5 万张、Inflection 要 2.2 万张、Meta 需要 2.5 万张、大型云厂商(Azure、GoogleCloud、AWS、Oracle),每家可能需要 3 万张,Lambda 和 CoreWeave 以及其他私有云可能总共需要 10 万张,Anthropic、Helsing、Mistral、Character,每家可能要 1 万张。

仅仅这几家公司,就已经需要 43.2 万张 H100,如果以每块约 3.5 万美元计算,GPU 的价值约为 150 亿美元。而这还没有包括字节、百度、腾讯等国内公司。

在 AI 大模型竞争上,榜上有名的几个国家:中国、美国、沙特阿拉伯、阿联酋,都是英伟达的座上宾。

沙特阿拉伯已通过公共研究机构阿卜杜拉国王科技大学(Kaust)购买了至少 3000 块英伟达的 H100 芯片。这些芯片将于 2023 年底全部交付,总价值约为 1.2 亿美元,用于训练 AI 大模型。

阿联酋也获得了数千颗英伟达芯片的使用权,并已推出自己的开源大语言模型「Falcon40B」,「Falcon40B」使用了 384 个 A100 芯片进行训练。

GPU 的出货量

英伟达 H100 的出货量也备受关注。研究机构 Omdia 披露,英伟达在 2023 年第二季度的 H100 出货量为 900 吨。按照单片 H100GPU 的重量约为 3 千克,那么英伟达在二季度售出了约 30 万片 H100。

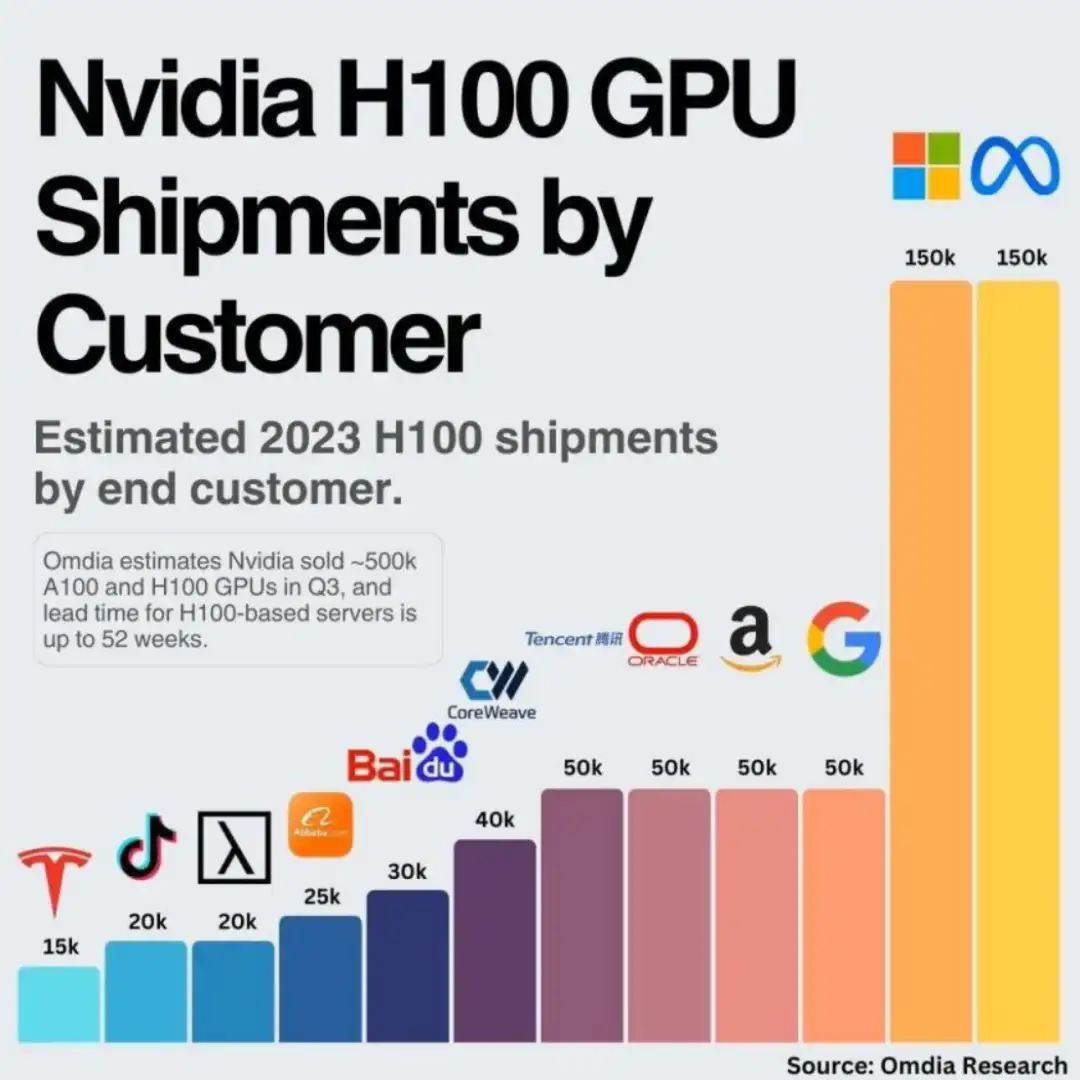

到了三季度,英伟达大约卖出了 50 万台 H100 和 A100 GPU。每家能够分到的 GPU 数量有限,Meta 和微软各自采购了 15 万个 H100GPU,谷歌、亚马逊、甲骨文和腾讯则各采购了 5 万片。

如此庞大的 GPU 需求量,导致基于 H100 的服务器需要 36~52 周的时间才能交付。按照英伟达官方的说法,2024 年一季度之前的 GPU 芯片早已全部售罄。

业内预估,明年英伟达的出货量将达到 150 万-200 万颗。

2024,GPU 能降价吗?

GPU 能否降价,还要看明年的供需情况。上图是 GPUUtils 列出的目前对 GPU 市场供需变化最有直接影响的科技公司,包括了:开发出 Chat-GPT 的 OpenAI、台积电、微软、Meta 以及成立仅仅一年便募得 13 亿美元资金的 AI 新创 Inflection。

买方

有的人不想买。谷歌、Meta 都觉得英伟达的 GPU 太贵了。

Meta 最近已经宣布构建了自己的 DLRM 推理芯片,并且得到广泛部署。Meta 大大方方承认,自己即将发布的 AI 芯片并不能直接替代英伟达的芯片,但是自研芯片可以降低成本。

就算在谷歌 I/O 开发者大会两个小时的演讲中,谷歌方面一直在赞赏英伟达的 H100GPU 芯片。这也不妨碍,谷歌开始「骑驴找马」,谷歌的云服务器上已经用上了自家 TPU。

Google TPU v5e 于 2023 年 8 月发布,成为人工智能硬件领域的强大力量,专为大型语言模型和生成式人工智能量身定制。与前代产品相比,TPUv5e 的每美元训练性能显著提高 2 倍,每美元推理性能显著提高 2.5 倍,可大幅节省成本。其突破性的多片架构可实现数万个芯片的无缝连接,突破了以往的限制,为处理海量人工智能任务开辟了途径。

有的人不能买。中国是英伟达的第三大市场,占据其收入的 1/5 以上。随着美国政府宣布进一步禁止中国销售英伟达 H800 和 A800 芯片,卖不出去的 GPU,必然会对英伟达产生负面影响。

此外,明年 AI 或许迎来退潮。2023 年的 AI 热潮,除了大模型震惊业界外,炒作的因素也不在少数。毫无疑问,ChatGPT 是 2023 年的世界顶流。因为它,OpenAI 网站的流量在 4 月份就超过了 18 亿,进入了全球流量排名前 20。然而,网络分析公司 Similarweb 公布的数据显示,在狂飙半年后,ChatGPT 的访问量首次出现负增长,6 月份的访问量环比下滑 9.7%。

在大模型创业狂飙 200 多天后,探索者们的心态,从理想亢奋来到现实落地。大模型的维护依赖大量的高性能芯片,而单要建构、维护生成式 AI 工具的成本就非常巨大。这对于大公司而言还好,但是对于许多组织与创作者而言,这却是一笔难以负担的支出。

对于生产式 AI,2024 年还会再次迎来大众的检验。行业分析师认为,2023 年关于生成式人工智能的炒作非常大,AI 被过度吹捧,因为相关技术需要克服许多障碍才能将其推向市场。

退潮之后,能够剩下的高性能 GPU 需求还能有多少?

卖方

我们先来看看英伟达这个最大的卖家。优先关注两个方面:能不能供应足够的 GPU,明年是否有新品刺激市场需求。

第一个供货方面,众所周知,英伟达只与台积电合作生产 H100,台积电一共有 4 个生产节点是为 5nm 芯片提供产能:N5、N5P、N4、N4P。而 H100 只在 N5 或者是 N5P 的中的 4N 节点上生产,这是一个 5nm 芯片的增强型节点,同时英伟达还必须与苹果、AMD 和高通共享这个节点的产能,至于 A100 显卡则是在台积电的 N7 生产线制作的。从短期的情况看,三星和英特尔都因为制程技术的问题,无法替英伟达缓解供应紧张的问题。因此,预计明年市场,英伟达的 GPU 供应仍会紧缺。

第二个新品方面,英伟达在 2023 年 11 月底时,发布了 H100 的下一代继承者——H200。表示在处理 Llama2 等 LLM 时,H200 的推理速度比 H100GPU 提高了近 2 倍。从 2024 年开始,亚马逊网络服务、谷歌云、微软 Azure 和甲骨文云基础设施将成为首批部署基于 H200 实例的云服务提供商。尽管还没有公布 H200 的价格,但一定比 H100 目前每台 2.5 万美元至 4 万美元的价格更加昂贵。

从两个方面看,英伟达的 GPU 供需还存在较大的不确定性。不过。卖家市场,会有更多厂商加入。

明年 GPU 的另一大卖家,就是回过神来的 AMD。

从最近的财报来看,AMD 预计四季度 GPU 收入将达到 4 亿美元,到 2024 年底将超过 10 亿美元。其 CEO 苏姿丰对明年充满期待:「MI300 将成为自 2020 年后,销售额达到 10 亿美元最快的产品。」

2023 年 11 月,AMD 正式发布了对标 H100 的产品——MI300。据 AMD 展示,由 8 块 MI300X 组成的服务器在大模型推理方面的表现,要比同样规模的 H100 速度最高提升 1.6 倍之多。对于 AMD 来说,这种直接对标,实属罕见。

有意思的是,Meta、微软和 OpenAI 公司在 AMD 投资者活动上表态,未来他们将会使用 AMD 最新的人工智能(AI)芯片 InstinctMI300X。

不过,英伟达对 AMD 的对标也态度强硬,官方发布博客,驳斥 AMD 的评测不客观。英伟达表示,如果 H100GPU 使用了优化过的软件进行正确的基准测试,它的性能将大大超过 MI300X。

由于 MI300 还未正式应用,对于我们对于 AMD 和英伟达之间的「官司」很难分说,但不论如何,AMD 已经走到了高性能 GPU 的起跑线。

总而言之,2024 年的 GPU 还充满变数。在 AI 大模型冷静后、在买家不想当冤大头后、在卖家越来越多后,GPU 还会维持天价吗?相信各位看官心中自有答案。从市场的角度看,无论是当下多先进的技术,到最后终将会越来越普世。就看 GPU 玩家们,在 2024 年如何进攻战场了。

评论