“X”PU的时代,DPU位置何在?

艾新博盛投资合伙人 曹幻实 (左) 矩向科技CEO 黄朝波(右)

三类视角看DPU的兴起

“X”PU的时代,DPU位置何在?

超异构处理系统,解决海量存储大需求

拒绝碎片化,通用才是硬道理

市场前景广阔,DPU将大有作为

点击收听大咖谈芯现场实录↓↓↓

三类视角看DPU的兴起

幻实(主播):大家好,我是芯片揭秘的主播幻实。节目录了很多期却还没请过DPU方向的从业者和我们分享这一行的发展现状,今天很高兴矩向科技的CEO黄朝波先生作为DPU赛道的科普人做客我们节目,先请他来跟我们大家打个招呼。

黄朝波(嘉宾):大家好,我是矩向科技的黄朝波,很高兴来到芯片揭秘跟大家分享。

幻实(主播):黄总非常谦逊,了解到您曾经写过一本书,叫《软硬件融合——超大规模云计算架构创新之路》,您本人也被业界认为是相关技术的布道者。2020年10月,英伟达GTC大会上官宣了一款新处理器——DPU,我知道黄总对这一块很有心得,所以先请您聊一聊是怎样和DPU结缘的?

《软硬件融合——超大规模云计算架构创新之路》书影

黄朝波(嘉宾):DPU的发展是亚马逊最先开始的。2017年底,亚马逊AWS在re:Invent大会上宣布了它的NITRO系统,这个系统其实就是现在大家说的DPU。也是从这时候开始,NITRO就成为了整个亚马逊云服务的技术底座。我也是因为这个大的背景原因,在2018年初加盟了UCloud,来做类似的一些工作。

关于DPU 的兴起,我们可以从三个视角来看。

第一个视角就是云计算公司的视角,像亚马逊、阿里云等,它们从虚拟化出发。那么虚拟化是什么呢?虚拟化分为三部分:处理器的虚拟化、内存的虚拟化和I/O的虚拟化。处理器和内存的完全硬件虚拟化都是由CPU芯片完成的,但I/O的虚拟化一直都是软件模拟的。现在因为主机CPU的性能瓶颈之后, I/O虚拟化的代价非常之高,所以他们要想办法把这些工作“下沉”到硬件中,最终的做法就是把整个基础设施层整体放在独立的硬件中完成。

还有另外一个视角,就是现在英伟达或一些智能网卡公司的看法。它们认为,DPU是整个数据I/O的加速,因为数据要在不同服务器之间进行大量的传输和处理,他们的视角就是用硬件来专门优化数据的搬运和处理。

最后还有一个点,其实是更本质的,那就是计算。因为所有工作最终都要归结到计算。CPU已经到了性能瓶颈,不得不通过硬件加速的方式来不断提升性能。

以上三个视角其实各有不同,但是有一点是一致的——那就是如果我们只站在一个视角去考虑问题,做出来的东西很有可能有失偏颇。只有把不同的视角都考虑清楚,这样做出来的东西才是均衡的、全面的。

“X”PU的时代 ,DPU位置何在?

幻实(主播):现在这种概念非常多,最传统的有CPU,GPU,DPU,后续还有NPU,每家都说自己不一样,很厉害。很多人戏称现在是“X”PU的时代,因为都不知道前面还会出现什么字母。趁此机会,您也跟我们讲一讲那么多“PU”是指什么,DPU又处在什么角色和位置?

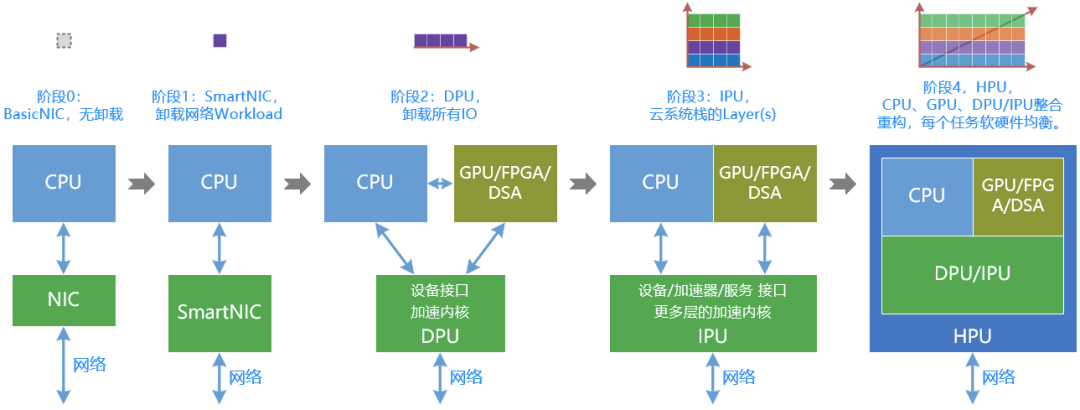

黄朝波(嘉宾):用一条主线可以帮大家把这些概念都梳理清楚,这条主线其实就是它内部所在的这些处理引擎。比方说之前Graphcore提出的IPU,再有像NPU、NP,很多PU其实内部只有一种类型的处理引擎,这些引擎拼成了一颗芯片。但这颗芯片是无法独立工作的,需要通过CPU+XPU异构计算的方式工作。DPU和它们最大的不同在于它本身是一个SoC,内部包含了很多不同类型的处理引擎,既可以独立工作,也能作为CPU的加速助手一起协同工作。

(图源:软硬件融合公众号)

幻实(主播):听起来DPU特别复杂,又能协同又能独立,那独立的话是不是意味着它很难做?

黄朝波(嘉宾):的确是这样的。例如我们讲AI处理器,它就只关注AI这个领域;讲网络处理就关注网络的领域。但是DPU不一样,它要关注的领域非常多,首先就是虚拟化,其次还有网络、存储、安全等,另外还要关注怎么去把云服务“下沉”到里面,这就涉及方方面面软件、硬件的综合能力了。各方面的知识都非常多,要把各种资源整合在一起,这的确是DPU面临的巨大挑战。

幻实(主播):刚刚您提到了CPU、GPU,在它们三者之间来定性的话,是优势互补还是未来有可能存在谁替代谁呢?

黄朝波(嘉宾):CPU、GPU和DPU就是现在大家称之为数据中心的三大处理器,其实它们三者是一个协同的关系,未来会朝着融合的方向发展。具体来说,我们可以把系统大体上分为三大部分:系统的底层称之为基础设施层,在此之上的应用层又可以分成两部分,一部分可以加速,另一部分难以加速。这样一来,基础设施层的工作就适合放到DPU里去完成,再把应用层里可加速的那部分放到GPU里,CPU负责兜底,不可加速的部分就只能放在CPU里。

为什么这样做呢?原因在于应用层里很多东西是不确定的,算法也会经常改变,还会面临不用的应用场景要用同一个硬件平台这种情况,而GPU刚好是相对弹性灵活的,这就使它非常适合用在上述场景中。

系统任务分类 (图源:软硬件融合公众号)

接下来讲三者的协同关系。由于现在chiplet(注:芯粒,是不同功能裸片的拼搭,某种意义上也是不同IP的拼搭)技术越来越流行;而且,并非所有的场景都要用到很重量的独立三芯片的大系统。很多场景其实是一种相对轻量的场景,那么我们就可以把三者合到一起,整合成一颗芯片,这是未来发展的趋势。

不过整合的过程并不是简单地把三颗芯片拼起来,否则它们还是各管各的三张皮。所谓的整合是要打破界限重新做架构,最终形成一个整体,我们称之为“超异构处理器”,这也是我们团队目前正在努力的方向。

超异构处理系统,解决海量存储大需求

幻实(主播):超异构处理器能够打破三者之间的边界。

黄朝波(嘉宾):对,把它合三为一。

幻实(主播):谁会去做“打破”的角色?因为它要用第三方视角来看,任何一方我估计都很难主动打破自己的模式或护城河去兼容别人。

黄朝波(嘉宾):其实它是需要一些落地策略的。比方说,一方面,我们可以把它先当做一个DPU的角色,用它承担CPU助手的工作。另一方面,内部很多通用性的功能,让它可以在其他的场景上落地,像存储服务器,以及更广阔的边缘服务器市场,它都是大有可为的。

幻实(主播):按照这种趋势看会大有可为,但感觉开发成本会十分昂贵。这两年我们发现很多做IP的公司生意都特别好,因为不少企业会花上亿的资金来买IP,投资人也得被动去接受这件事。我想问在您看来DPU除了前期买IP的费用特别高之外,未来的发展还会遇到什么阻碍?它会走怎样的技术发展或产品开发的路径?

黄朝波(嘉宾):DPU在前期大概会花费成本总额的50%左右用于购买IP,另外50%用于自研和整合。成本这块实际上不可避免,因为一开始相对而言比较弱小,许多技术在没有积累的时候也只能如此。不过当第一代产品开发起来以后,第二代、第三代自己贡献的价值就会越来越多,未来自研部分的成本和价值可能会到80%甚至90%。

其实难点在于DPU涉及的领域众多,并且每个领域都可能有很多路线之争,到底应该选择哪种路线或者制式?这就好比有10道选择题,只要有任何一道题做错了,都将前功尽弃,直接零分。为什么会这样?因为你给用户提供产品,而用户是一个综合性的场景,一旦某一种功能无法满足要求,那整体就落不了地。最大的挑战和风险就在这里,不仅要选正确的路线,还要更加前瞻。如果是定制设计,就意味着你最终覆盖的场景和用户数量一定会非常少,这时就要思考如何避免这种情况出现。

幻实(主播):这些也是投资人关心的事,会很担心你进入到一个非常狭窄的方向。

黄朝波(嘉宾):是的,这种狭窄会使得产品和市场碎片化,最后大家都变成了完全碎片化的状态。那么最合适的解决办法是什么样的?这需要把“通用”这个能力做出来。在许多方面我们自己其实不用选择路径,而是让用户来选,就相当于把选择题交给了用户来做,我们只把选择题的硬件提供出来。这样的话,做出来的东西肯定百分之百最满足用户自己的需求。

拒绝碎片化,通用才是硬道理

幻实(主播):听上去感觉非常定制化,那是不是要有很多种型号?

黄朝波(嘉宾):如果是刚才那种自己去选择不同的技术路径的时候,它会变成碎片化的东西。但如果我们做通用器件的话,一个器件就能够把这些场景的不同需求都满足。所以通用性是DPU设计中最核心的能力,也是最关键的。如果通用性做不好那么DPU就很难真正的落地。

幻实(主播):既然您觉得重点在通用性上,我想问问国外大厂比如说英伟达,他们在这个方面怎么样?

黄朝波(嘉宾):相对来说英伟达采用的是一种确定的定制方案,这也是为什么它在落地上存在困境的原因。大家面临的场景和困境是相同的,我们称其为“不同用户的场景差异化”。不仅如此,同一个用户的场景也在持续迭代。

目前来看,每当遇到问题后,行业里会有不同路径的做法。例如,有的公司会针对这种场景做出来一个自认为最优的方案,大家来跟随。但是可能会存在用户的业务逻辑实现和我们的不一样,并且用户的平台迁移风险和成本都非常高,因此芯片落地就存在困境。

还有一种做法是客户自研,自己需求什么就自研什么。它也存在一些问题,就是硬件的迭代周期其实赶不上软件的迭代周期。此外,大公司内部也有不同的团队,团队之间的需求也是千差万别的。

再有一个路径就是通用路径,并不试图帮助用户来决策,而是把权力交给用户,让他们自己来决定想要什么,我们提供的只是一个通用的平台而已。

幻实(主播):我发现目前国内做自动驾驶、汽车方向的公司其实也一样,因为每家主机厂的诉求是不同的。我们之前和地平线交流过,我发现他们很有意思,用户想要芯片可以,想要定制各种IP也可以,总之就是想要什么我都配合你来做。这一点和DPU很类似,不替用户做选择,只把自己的“武器库”准备的充分一点。需要团队的实力很强才能做到这种程度,通用性不是一般的高度。

黄朝波(嘉宾):是的,要求确实不低。我们面对的用户有千差万别的需求,做一千种、一万种这类芯片是不现实的。你要在成千上万的需求里找出共性,把共性变成硬件,再把差异性通过用户编程软件的方式去实现。这考验的是整个团队对需求、产品以及整个系统架构的全面把握,对能力的要求确实非常高。

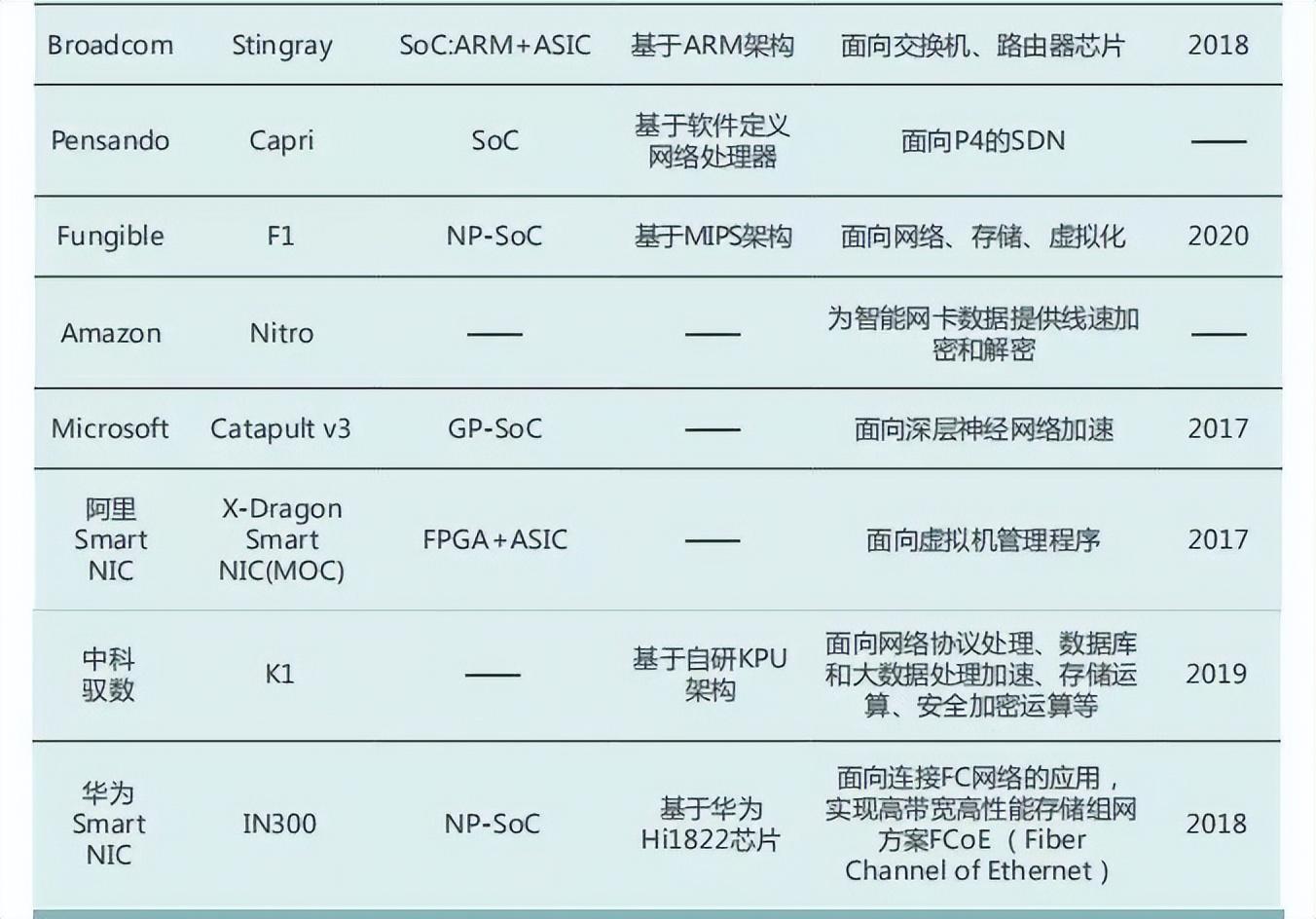

DPU竞争格局 (图源:智能计算芯世界)

幻实(主播):在您看来目前国内的DPU有没有按照这个方向来做布局的?

黄朝波(嘉宾):还没有。现阶段大家更多的还是考虑先把用户的需求拿到,再把东西实现好。从国际上看,有两家公司可能相对来说做得比较好,第一个当然是亚马逊。

亚马逊的第一代NITRO系统严格来说就是一颗CPU,非常通用但性能很差,它是通过5颗芯片共同来完成整个基础设施的工作。后面更新的第二代、第三代才逐渐把硬件加速部分放进去。并且,放的时候也非常的审慎,并没有把很多功能都固化,而是通过很多软件的方式,再去实现确定的功能。如此一来,它其实也是相对通用的器件了。尽管是自研自用,它也做得非常通用化。

幻实(主播):它是不对外提供的吗?

黄朝波(嘉宾):是的,并不对外提供。

幻实(主播):亚马逊的云之所以能被这么多科技公司所采用,其实还是有一些独到之处。

黄朝波(嘉宾):可以说它从上到下的整个技术链条都非常稳固。此外,英特尔在通用性这一块做得也不错。因为英特尔自身的数据中心业务经过了多年的深耕和技术沉淀,可以说它是最懂数据中心场景的芯片公司。目前他们所倡导的IPU内部的网络处理器支持P4编程,相对而言更加通用。它内部的CPU是Arm的Neoverse N1系列,性能非常强烈,通用性也非常好。另外它们还发起了开源IPDK(Infrastructure Programmer Development kit,基础设施编程开发套件)框架,发起了OPI(Open Programmable Infrastructure Project,开放可编程基础设施项目)联盟,所有这些都是为更加通用和开源开放的生态来服务的。

幻实(主播):这些也用在它的云服务上还是说它会单独把硬件板块对外开售?

黄朝波(嘉宾):它的IPU是对外出售的,对标的就是英伟达的DPU。但是在产品理念和具体实践上,我们还是比较认可英特尔的做法。

幻实(主播):是的,老牌做CPU的公司会更早知道产品的痛点在哪儿。国内目前还没有这种思路开展,哪怕我们有阿里云、腾讯云、华为云等等,可能还是按照传统的路径在做。

黄朝波(嘉宾):对,目前来说,阿里云在这一块其实做了很多的技术积累,但是它现在有很多技术分散在不同的部门,可能还需要一个整合的过程。接下来大家拭目以待,看它们后续资源整合的情况。

市场前景广阔,DPU将大有作为

幻实(主播):刚刚我们聊到了DPU这个行业的现状,请您来做个预判,未来它会按照什么节奏发展?又会形成什么样的态势?

黄朝波(嘉宾):这要分几个方面来说。

第一点要改变认知。现在大家对DPU的定位还停留在它是CPU的助手上,其实这会限制DPU自身的价值。更合适的做法是将DPU看做一个独立处理器,脱离CPU的约束,它才可以面对更广阔的的市场,这样才更有希望最终真正成功。

第二点是提升通用性。DPU一定要能实现更多的通用性,因为不通用的话它就完全碎片化了,可通用性又对设计的能力要求很高,对全系统的驾驭要求也非常高。只有把DPU做得更加通用才能实现性能的极致飞跃,用户完全可编程和定义一切的这种超异构处理器,才是DPU的未来。

第三点是市场前景。首先还是定位在数据中心服务器上,不但可以用在业务服务器中,也可以用在存储服务器里,还可以用在规模更大的边缘服务器上。如此一来,在国内DPU的市场经过我的测算就能达到1000亿元人民币的规模。

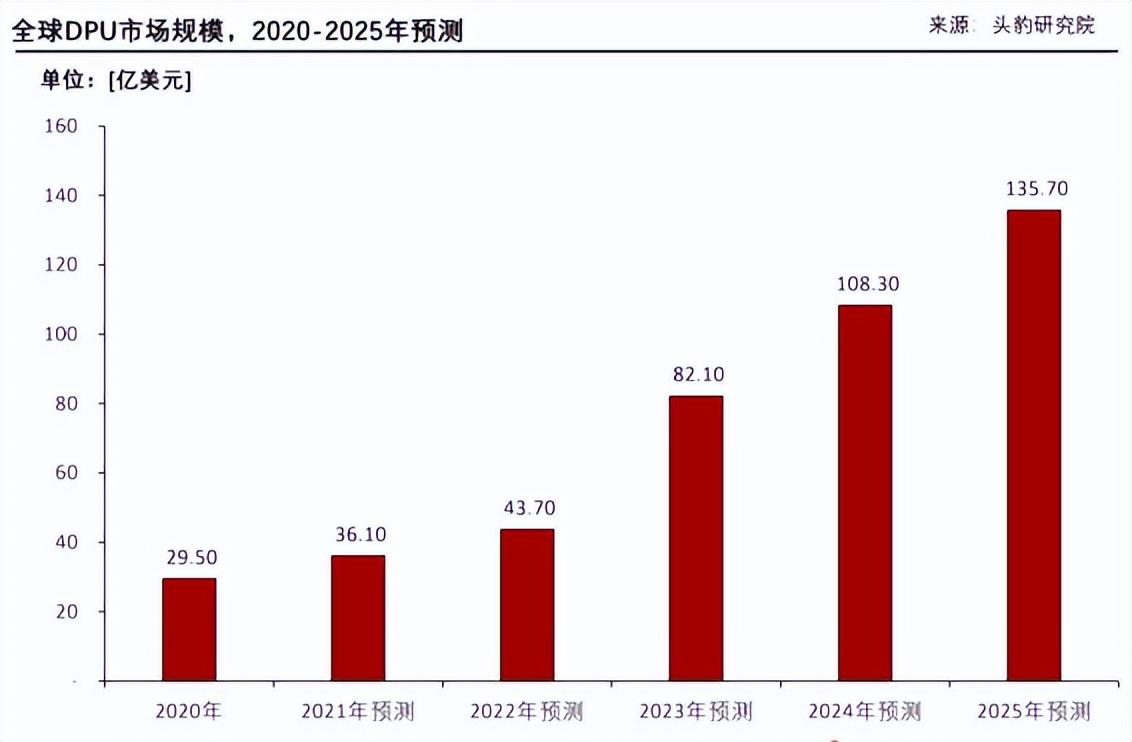

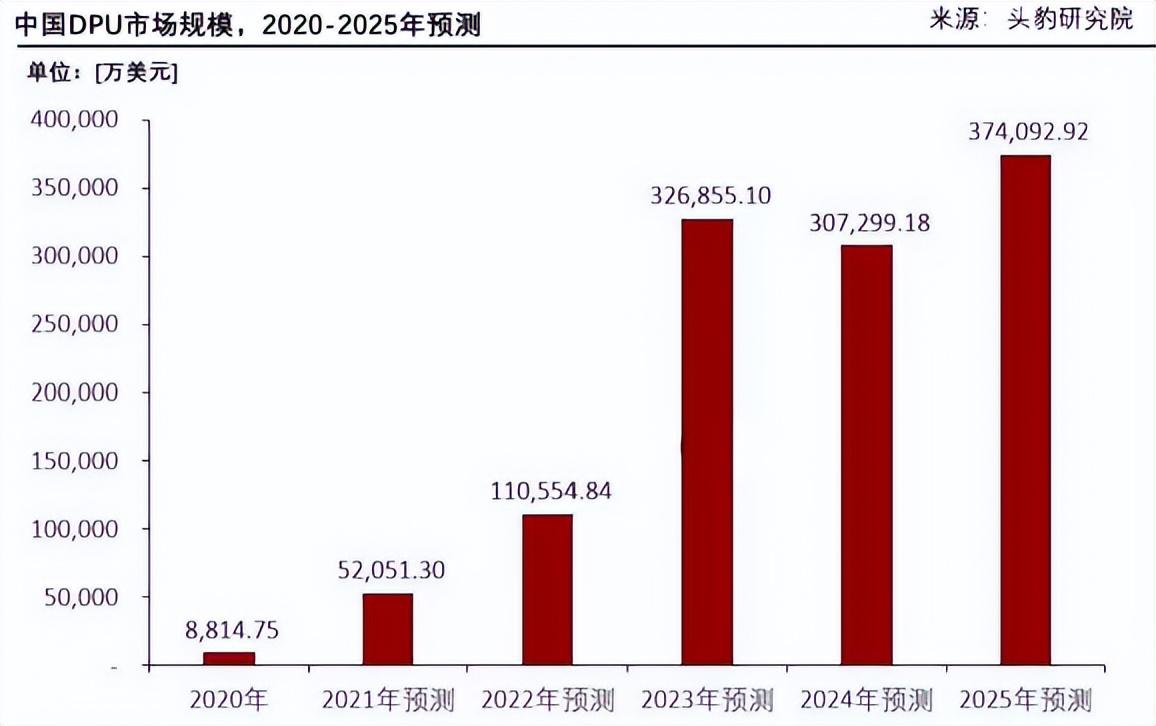

2020-2025年全球与中国DPU市场规模预测 (图源:头豹研究院)

幻实(主播):您觉得这几种服务器市场都能用到它?

黄朝波(嘉宾):对的。只有做到这一步才算成功,因为大芯片的研发成本非常高,如果仅仅覆盖碎片化的市场就会很难大规模落地。

幻实(主播):对于那种数据加倍的类似于冷存储的存储中心,对DPU有需求吗?

黄朝波(嘉宾):其实我刚才提到存储服务器大体上又可以分为三类:热存、温存和冷存。简单来说这里面最大的区别就是一颗处理器上能挂多少的存储量。比方热存可能挂的是12块到24块NVMe盘,这已经是极限了;在温存里可能挂的是HDD,这样的话其实相当于挂了五六十块甚至一百块盘;但是在冷存里,现在通过分组sleep/wake up的方式,大部分盘是处于睡眠的状态,所以可以用一颗处理器挂上千块归档型HDD盘。最终平均下来每一块盘、每一个存储容量的功耗和成本就会降得非常低,最终它还是用DPU这种SOC芯片来完成相关的处理。

幻实(主播):所以不要以为数据“睡眠”了就不需要硬件过多干涉了。

黄朝波(嘉宾):对,DPU其实一直在工作。再引申来看,既然它是一个算力和数量级都有所提升的超异构处理器,本质上只要在大算力场景中都能用得到,那么除了云和边缘的服务器,DPU还能用在其他市场中,比方5G核心网、自动驾驶等。例如英伟达在2024年将发布的自动驾驶芯片就是由高性能的CPU、GPU和DPU共同组成的,DPU属于三大核心计算部分之一。站着这个视角来讲,超异构处理器面向的是复杂的计算场景,这种场景在国内就有5000亿以上的市场规模。如果放眼全球,其实已经有数万亿的市场了。

幻实(主播):不得不说在数据爆发增长的情况下就需要灵活调用想办法。一些公司在日常办公可能会遇到云盘存储不够用的情况,这就是数据几何式增长的典型表现。

黄朝波(嘉宾):其实有过一些测算,数据在增长之后大概会有一半最终存在云端,另一半则沉淀在了终端或者边缘端。数据的量大了之后,无论是传输、处理、分析、存储、安全等,对硬件性能的要求都非常高。这些从本质看都是计算,那计算靠什么呢?靠的就是CPU、GPU、DPU,最终它们会被整合成为超异构处理器。

幻实(主播):是的,国家也提出了“东数西算”战略,今天我们讨论的话题很符合国家的科技大趋势和大方向。我知道您正在创业做这个方向,能否展开谈一谈您是以什么角度切入这个行业的?

黄朝波(嘉宾):我以前在Marvell做CPU,后来机缘巧合下去了UCloud做软硬件结合方面的工作,不仅仅是做芯片,我们的视角是如何在需求的驱动下把应用做到最好。做久了之后,我最大的一个体会就是软硬件其实是割裂的,软件不懂硬件,硬件不懂软件。现有的技术体系,平台构建好之后,大家都在上面开发软件,但很难把这些软硬件打开,然后重新再整合。所以这也是我后来写了一本书叫《软硬件融合——超大规模云计算架构创新之路》的原因。在工作中我们思考更多的是要从需求出发,深层次的需求到底是什么?

最开始我们是做虚拟化,发现已经形成的软件应用性能还不够好,但业务逻辑不敢轻易动,因为它里面承载的云服务是千亿、万亿级别的规模,所以只能靠硬件来加速和提升性能,后续业务的更新迭代也要在自己的掌控之下。这样就需要,我们做硬件时并不给用户提供具体功能,而是提供一个工具和平台让他们自己来实现这些功能。这就是所谓深层次“需求”。

幻实(主播):您现在就在做这样的平台。

黄朝波(嘉宾):是的,以前我是甲方,现在我是乙方。做更好的产品,让之前的自己用的更爽。

幻实(主播):对,现在的自己去服务当年的自己。技术创新都源自最真实的需求,这很有价值。我们也在这里做个宣传,如果有想要体验DPU的可以来找黄总试试看。

黄朝波(嘉宾):目前我们基于FPGA做了一些原型的产品,如果做芯片的话投入会更大。现在矩向科技处于融资状态,已经有的原型可供大家来体验一下。

幻实(主播):我觉得这是一条新的赛道、新的路线。体验过后可能会发现跟以前的感受完全不一样了。非常开心今天向黄总请教了很多知识,也希望在数据中心领域,国内的公司不要和国外差距太大,很感谢有你们这样的团队在做这些事。

黄朝波(嘉宾):也谢谢曹总可以提供这样的机会,让我们能够分享自己的一些看法。

幻实与黄朝波先生合影

作为数据中心里继CPU和GPU之后的“第三颗主力芯片”,DPU的出现称得上是异构计算中的阶段性标志,近年来已逐步掀起了一波行业热潮。根据Canalys Cloud Channels Analysis预测,到2023年,中国DPU市场规模将达190亿人民币。当然,还有其它分析机构的预测更加乐观,认为中国DPU市场规模预计将在2025年超过37亿美元,约合240亿人民币。

不过,DPU的使用门槛非常高,只有开发、整合能力较强的用户才能充分利用它。在推向市场的过程中,由于DPU涉及的领域很分散,往往造成碎片化应用的局面,这无疑是一种算力浪费。为了解决这一难题,就需要设计出通用的平台来承载用户丰富、多样和自定义下的使用场景,从而满足个性化需求。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。