AI硬件核心HBM,需求爆发增长

2022年末,ChatGPT的面世无疑成为了引领AI浪潮的标志性事件,宣告着新一轮科技革命的到来。从ChatGPT掀起的一片浪花,到无数大模型席卷全球浪潮,AI的浪潮一浪高过一浪。

本文引用地址://m.amcfsurvey.com/article/202405/458523.htm在这波浪潮中,伴随着人才、数据、算力的不断升级,AI产业正展现出巨大的潜力和应用前景,并在多个领域展现出重要作用。AI的快速发展对算力的需求呈现井喷的态势,全球算力规模超高速增长。在这场浪潮中,最大的受益者无疑是英伟达,其凭借在GPU领域的优势脱颖而出,然而对于AI的大算力需求,人们的眼光全部都在GPU上,但另一个硬件同样也是核心,那就是HBM,AI 硬件核心是算力和存力,HBM高带宽、低功耗优势显著,是算力性能发挥的关键。

HBM是一款新型的CPU/GPU内存芯片。其将很多个DDR芯片堆叠在一起后和GPU封装在一起,实现大容量、高位宽的DDR组合阵列。通俗来说,传统的DDR就是采用的"平房设计"方式,HBM则是"楼房设计"方式,从而可实现了更高的性能和带宽,因此,其将传输信号、指令、电流都进行了重新设计,而且对封装工艺的要求也高了很多。

其实最开始设计HBM的初衷,就是为了向GPU和其它处理器提供更多的内存。这主要是因为随着GPU 的功能越来越强大,需要更快地从内存中访问数据,以缩短应用处理时间。例如,AI和视觉,具有巨大内存和计算和带宽要求。

所以我们可以看到,在AI场景中,英伟达的GPU芯片不再是单独售卖:从流程上,英伟达首先设计完GPU,然后采购海力士的HBM,最后交由台积电利用CoWoS封装技术将GPU和HBM封装到一张片子上,最终交付给AI服务器厂商。最终产品结构正如海力士的宣传材料展示的一样。

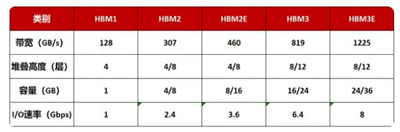

目前,HBM产品以HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)、HBM3E(第五代)的顺序开发,最新的HBM3E是HBM3的扩展版本。迭代方向是提高容量和带宽,容量可以通过堆叠层数或增加单层 容量获得提升,带宽提升主要是通过提升 I/O 速度。

过去几年来,HBM产品带宽增加了数倍,目前已接近或达到1TB/秒的里程碑节点。相较于同期内其他产品仅增加两三倍的带宽增速,HBM的快速发展归功于存储器制造商之间的竞争和比拼。

下一代HBM4有望于2025-2026年推出。随着客户对运算效能要求的提升,HBM4在堆栈的层数上,除了现有的12hi(12层)外,也将再往16hi(16层)发展,更高层数也预估带动新堆栈方式hybrid bonding的需求。HBM4 12hi产品将于2026年推出,而16hi产品则预计于2027年问世。

HBM突破了内存容量与带宽瓶颈,可以为GPU提供更快的并行数据处理速度,打破“内存墙”对算力提升的阻碍。凭借诸多优势,HBM成为AI时代的“新宠”,受到各大厂商的追捧,市场需求强劲。

目前主流 AI 训练芯片都使用 HBM,一颗 GPU 配多颗 HBM。以英伟达 H100 为例,1 颗英伟达 H100 PICe 使用台积电 CoWoS-S 封装技术将 7 颗芯片(1 颗 GPU+6 颗 HBM)封在一起,1 颗 GPU 由 6 颗 HBM 环 绕,其中 5 颗是 active HBM,每颗 HBM 提供 1024bit 总线位宽,5 颗 共提供 5120bit 总线位宽,另外 1 颗是 non-HBM,可使用硅材料,起到 芯片的结构支撑作用。H100 PCIe 的 HBM 总容量 80GB,使用 5 颗 activer HBM2E,每颗 HBM2E 容量 16GB,每颗 HBM2E 是由 8 层 2GB DRAM Die 堆叠组成。

并且AI浪潮还在愈演愈烈,HBM今后的存在感或许会越来越强。据semiconductor-digest预测,到2031年,全球HBM市场预计将从2022年的2.93亿美元增长到34.34亿美元,在2023-2031年的预测期内复合年增长率为31.3%。

2025年HBM价格调涨约5~10%,占DRAM总产值预估将逾三成

这样的市场表现,无疑证明了HBM在市场上的巨大潜力。它不仅仅是一种存储芯片,更是AI时代的“金矿”。 HBM也是AI芯片中占比最高的部分,根据外媒的拆解,H100的成本接近3000美元,而其中占比最高的是来自海力士的HBM,总计达到2000美元左右,超过制造和封装,成为成本中最大的单一占比项。

目前全球量产的只有海力士、三星、美光科技三家公司,2022年HBM市场份额中,SK海力士独占50%,三星约40%,美光仅10%,且SK海力士是目前唯一量产HBM3的公司。

SK海力士

在人工智能的天空中,有三颗星辰璀璨夺目,它们分别是英伟达、台积电,但还有一家公司也占据了AI食物链的顶端,却鲜为人知,它就是——海力士。

海力士虽然在公众视野中的曝光度不如英伟达及台积电,但其在存储技术领域的影响力不容小觑。作为全球领先的存储解决方案供应商之一,海力士在提供高性能、高稳定性的DRAM和NAND闪存产品方面,有着不可替代的地位。它的产品广泛应用于数据中心、移动设备和个人电脑等,是支撑现代信息社会运转的基石之一。

虽然HBM非常昂贵,但随着AI基础算力需求的大爆发,草根调研显示当前HBM仍是一芯难求,海力士2024年所有的产能都已经完全被预定,行业的供需失衡可能在2025年也仍无法得到有效的缓解。

早在10年前的2013年,海力士就首次制造出HBM,并被行业协会采纳为标准。2015年,AMD成为第一个使用HBM的客户。但在此之后,HBM由于价格高昂,下游根本不买单,甚至一度被认为是点错了科技树。

但海力士依然在这个方向持续深耕,并没有放弃。在2015-2022年,虽然并没有什么突出客户,海力士仍然对HBM产品进行了多达3次技术升级,丝毫不像对待一个边缘产品的待遇。最终,凭借着2023年至今的AI浪潮,海力士的HBM一芯难求,从无人问津到一飞冲天,10年的坚守终于换了回报。在低迷的韩国股市中,海力士股价也一骑绝尘,实现翻倍,成为跟上全球AI浪潮的唯一一家韩国公司。

在很长一段时间内,SK海力士都是英伟达HBM的独家供应商。2023年SK海力士基本垄断了HBM3供应,今年其HBM3与HBM3E的订单也已售罄。作为英伟达HBM的主要供应商,过去一年中,SK海力士股价飙升超过60%。

累计上涨100%还不停!消息称SK海力士将对内存等涨价至少上调20%

近期,SK海力士透露,其下一代 HBM4 内存将于2024年着手开发,2026年开始大规模生产,届时将为英伟达Blackwell B100的下一代 AI GPU 提供支持。此外,SK 海力士还计划在 HBM4 也采用先进 MR-MUF 技术,从而实现 16 层堆叠,正在积极研究混合键合(Hybrid bonding)技术。MR-MUF 技术与过去的工艺相比,将芯片堆叠压力降低至 6% 的程度,也缩短工序时间,将生产效率提高至 4 倍,散热率提高了 45%;同时 MR-MUF 技术在维持 MR-MUF 优点的同时采用了新的保护材料,得以使散热性能改善 10%。

SK海力士开发新一代移动端NAND闪存解决方案“ZUFS 4.0”

OpenAI首席执行官本周访韩,预计将与SK集团会长讨论AI芯片合作

据日经新闻报道,英伟达正在寻求从三星购买HBM芯片,那这个消息再次印证了HBM的紧缺性。光是英伟达一家公司已经吃光了SK海力士和美光的产能,这还不够,还要再吃下三星新建的产能。

内存领域的霸主三星,得益于在DRAM上的深厚积累,以及并不落后的技术储备,迅速崛起成为HBM排名第二的玩家。

黄仁勋:三星是一家非常优秀的公司,英伟达正验证其 HBM 内存

2016年三星开始大规模量产HBM。落后于海力士3年;而根据公司最新进展,三星已经于2023年实现了HBM3的量产出货,而将在今年上半年推出HBM3E,而且规划2025年实现HBM4的量产。根据这一规划,三星与海力士的差距已经缩小到半年左右,而差距有望于2025年被完全消除。

三星存储业务重心转向企业领域:目标今年 HBM 产量增加 3 倍,明年再翻番

三星除了有DRAM的底气之外,由于HBM当中包含部分逻辑芯片的电路,因此三星电子依托于自有的逻辑晶圆厂,确实具备弯道超车的比较优势。而且同为韩国公司,直接挖相关人才也更为容易。

三星组建HBM产能质量提升团队,加速AI推理芯片Mach-2开发

不久前,三星成功地跻身英伟达的供应链,这让其在HBM领域的地位进一步得到了加固。此举也彰显了三星与AMD之间的深厚合作,据悉,三星的HBM3产品已经通过了AMD的验证,可谓是实力不俗。

而眼下,HBM3e的光芒也逐渐浮出水面。这种新一代高带宽内存规格被认为将成为未来市场的主流。SK海力士率先通过了验证,美光也已经开始推出HBM3e产品。而三星也在这个战场上抢滩登陆,其HBM3e产品预计将在第一季末前通过验证,并开始大规模出货。

作为全球唯一一家同时在存储芯片和逻辑芯片领域均处于领跑集团的公司,三星计划在未来几年内斥资超400亿美元,建立一整套半导体研发和生产生态。

毫无疑问,在HBM领域起了个大早的韩国,也丝毫没有放松,还在朝前一路狂奔。

三星否认将 MR-MUF 堆叠方案引入 HBM 生产,称现有 TC-NCF 方案效果良好

三星发布其首款36GB HBM3E 12H DRAM,满足人工智能时代的更高要求

美光

近期美光透露,今年其HBM产能销售一空,明年绝大多数产能已被预订,并且其上月表示,已开始量产其高带宽存储半导体HBM3E,用于英伟达的H200 Tensor Core GPU。

光科技过去一年半来股价飞涨,分析师以存储产品报价转强为由,将美光投资评等从中立调高至表现优于大盘,2024年目标价从原本的115美元上修至150美元。并且其HBM产品有望在2024会计年度创造数亿美元营业额,HBM营收预料自2024会计年度第三季起为美光DRAM业务以及整体毛利率带来正面贡献。美光今年HBM产能已销售一空、2025年绝大多数产能已被预订。另外预期2024年DRAM、NAND产业供给都将低于需求。

HBM 的高需求,加之其对晶圆的高消耗,挤压了其他 DRAM 的投片量。美光表示非 HBM 内存正面临供应紧张的局面。

此外,美光宣称其 8Hi HBM3E 内存已开始大批量出货,可在截至 8 月末的本财年中贡献数亿美元的收入。

评论