AI 芯片:一场烧钱的疯狂竞赛

众所周知,企业,尤其是超大规模企业和云计算构建商,都希望可以利用生成式人工智能,目前他们正在花费巨资购买人工智能加速器和相关芯片,以创建人工智能训练和推理集群。

本文引用地址://m.amcfsurvey.com/article/202407/461342.htm不过,你想要试着算一算到底花了多少钱却很困难。因为很难划清人工智能芯片与构成系统的周边设备之间的界限。估算人工智能市场规模的部分问题在于,没有人真正知道服务器在制造和销售之后会发生什么,以及它被用来做什么。举例来说,你怎么知道一台装载了 GPU 的机器到底做了多少 AI 工作或 HPC 工作?

早在 12 月份假期结束时,笔者就深入研究了 IDC 的 GenAI 支出预测,该预测非常吸引人,因为它将 GenAI 工作负载与其他类型的 AI 区分开来,并讨论了构建 GenAI 系统所需的硬件、软件和服务支出。当然,笔者也提到了 AMD 首席执行官苏姿丰在 2022 年和 2023 年就各类数据中心人工智能加速器(包括 GPU 和所有其他芯片)提出的最初和修订后的总目标市场。

要提醒大家的是,苏姿丰表示,数据中心 AI 加速器的目标市场总额在 2023 年约为 300 亿美元,到 2027 年底将以约 50% 的复合年增长率增长到 1500 亿美元以上。但一年后,随着 12 月 "Antares "Instinct MI300 系列 GPU 的发布,GenAI 热潮骤然升温,苏姿丰表示,AMD 预计 2023 年数据中心 AI 加速器的市场规模为 450 亿美元,到 2027 年将以超过 70% 的复合年增长率增长,达到 4000 亿美元以上。

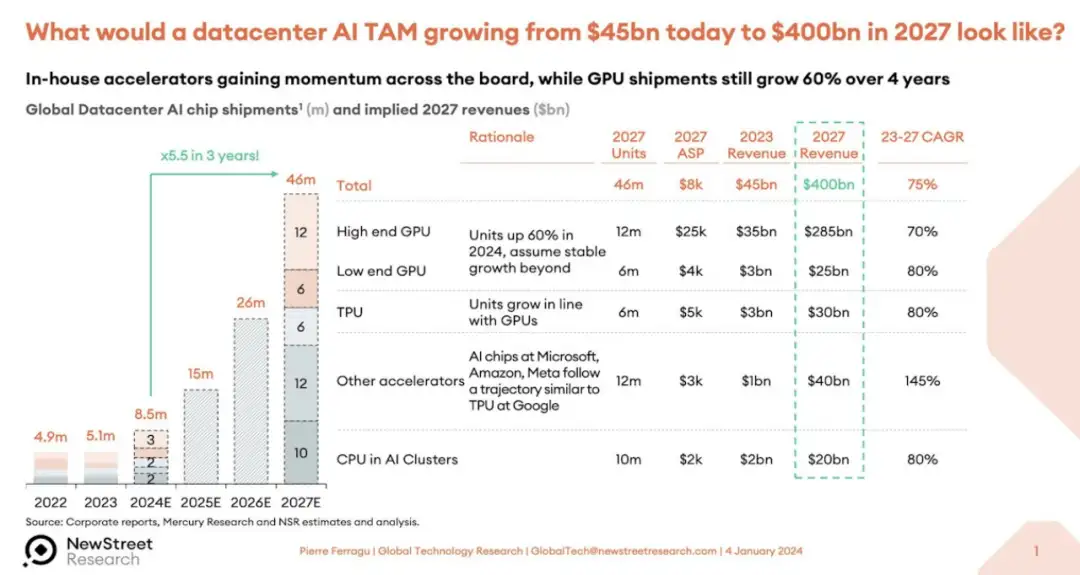

这还仅仅是加速器,而不是服务器、交换机、存储和软件。New Street Research 的 Pierre Ferragu 团队在科技领域做了很多工作,他们在推特上发布了一份关于 4000 亿美元数据中心加速器 TAM 可能如何细分的报告。

这是一个非常大的数字,它假定在 TAM 预测期结束时,人工智能服务器、存储和交换机的销售额约为 1 万亿美元。

从 2024 年开始,笔者从富国银行股票研究公司(Wells Fargo Equity Research)董事总经理兼技术分析师亚伦-瑞克斯(Aaron Rakers)那里获得了 GPU 的销售预测,并在电子表格中找到了一些乐趣。该模型涵盖了从 2015 年到 2022 年的数据中心 GPU 销售情况,并对 2023 年(预测时数据中心 GPU 销售尚未结束)和 2027 年进行了预测。富国银行的预测模型也早于 AMD 最近几个月做出的修订预测,AMD 称 2024 年 GPU 销售收入将达到 40 亿美元。

无论如何,富国银行的模型显示,2023 年 GPU 的销售额为 373 亿美元,全年出货量为 549 万台。出货量几乎翻了一番,其中包括各种 GPU,而不仅仅是高端 GPU。GPU 收入增长了 3.7 倍。根据预测,2024 年的数据中心 GPU 出货量将达到 685 万块,同比增长 24.9%,收入将达到 487 亿美元,同比增长 28%。根据预测,2027 年的 GPU 出货量将达到 1351 万个,数据中心 GPU 销售额将达到 953 亿美元。在这个模型中,英伟达在 2023 年的收入市场份额为 98%,到 2027 年才下降到 87%。

最近,Gartner 和 IDC 都发布了一些关于人工智能半导体销售的统计和预测,我们不妨对它们进行一下了解,以便尝试估计一下人工智能芯片市场的现状,以及若干年后可能出现的情况。

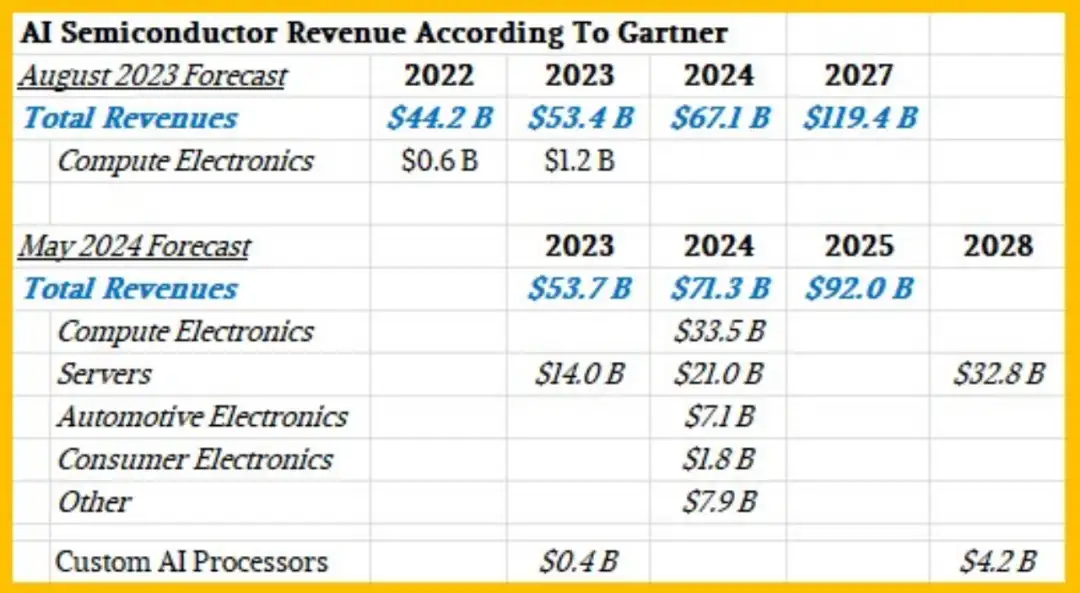

从 Gartner 开始。将近一年前,Gartner 发布了一份关于 2022 年人工智能半导体销售额的市场研究报告,并对 2023 年和 2027 年的销售额进行了预测;几周前,Gartner 又发布了一份修订版预测报告,对 2023 年的销售额进行了预测,并对 2024 年和 2028 年的销售额进行了预测。第二份报告的市场研究还包含一些统计数据,这里将其添加到下表中。

Gartner 公司副总裁兼分析师 Alan Priestly 表示,到 2026 年,所有售出的个人电脑芯片都将是人工智能个人电脑芯片,因为所有笔记本电脑和台式机 CPU 都将包含某种神经网络处理器。

用于加速服务器的AI 芯片是关注的重点,这些芯片的收入(假设不包括其所附带的 HBM、GDDR 或 DDR 内存的价值)在 2023 年为 140 亿美元,预计在 2024 年将增长 50%,达到 210 亿美元。但在 2024 年至 2028 年期间,服务器用人工智能加速器的复合年增长率预计仅为 12% 左右,销售额将达到 328 亿美元。Priestly 表示,像 TPU 以及亚马逊网络服务的 Trainium 和 Inferentia 芯片(仅举两例)这样的定制 AI 加速器在 2023 年只推动了 4 亿美元的收入,到 2028 年也只能推动 42 亿美元的收入。

如果人工智能芯片的价值占计算引擎价值的一半,而计算引擎的价值占系统成本的一半,那么这些相对较小的数字加起来,就可以从数据中心的人工智能系统中获得相当大的收入。

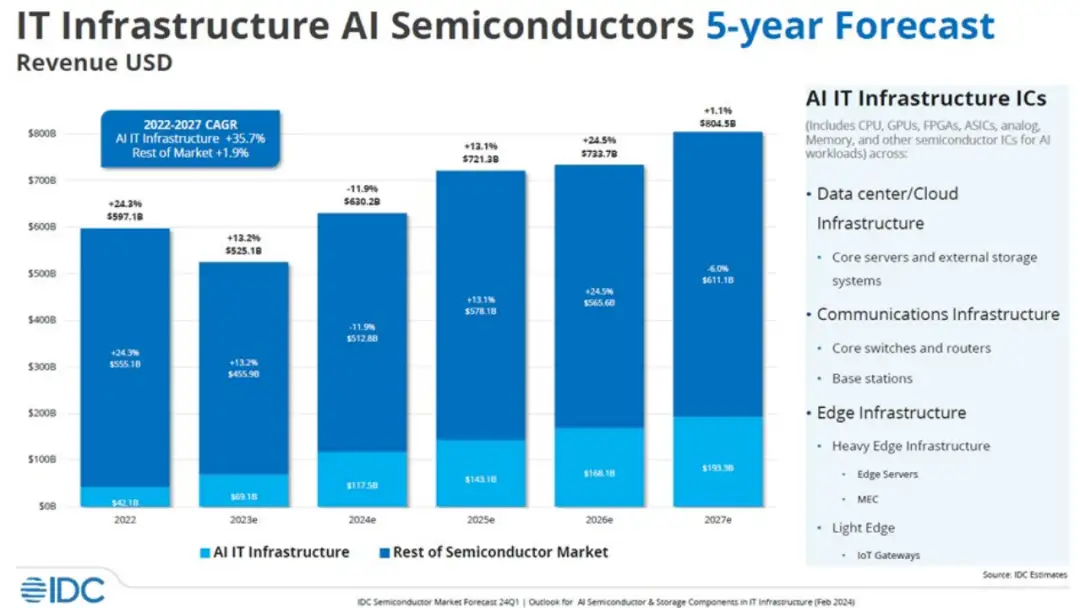

现在,让我们来看看 IDC 是如何看待人工智能半导体和人工智能服务器市场的。该公司几周前发布了这张有趣的图表。

在这张图表中,IDC 将 CPU、GPU、FPGA、定制 ASIC、模拟设备、内存和其他用于数据中心和边缘环境的芯片的所有收入汇总在一起。然后,再剔除计算、存储、交换机和其他设备的收入,因为这些设备适用于人工智能训练和人工智能推理系统。这不是所有系统的价值,而是系统中所有芯片的价值;因此不包括机箱、电源、冷却、主板、立卡、机架、系统软件等。如图所示,该图表包含 2022 年的实际数据,并仍在估算 2023 年至 2027 年的数据。

在 IDC 的这份分析中,半导体的人工智能部分从 2022 年的 421 亿美元增长到 2023 年的预计 691 亿美元,2022 年到 2023 年的增长率为 64.1%。IDC 认为,今年的人工智能芯片收入(这并不仅仅指 XPU 的销售额,而是指数据中心和边缘的人工智能系统中的所有芯片内容)将增长 70%,达到 1,175 亿美元。如果计算 2022 年至 2027 年的数字,IDC 预计数据中心和 AI 系统中的AI 芯片内容的总收入将以 28.9% 的年复合增长率增长,到 2027 年达到 1933 亿美元。

该图表的博文发表于 5 月底,是基于 2 月份的一份报告。在那篇文章中,IDC 添加了一些服务器收入的数字,将人工智能服务器与用于其他工作负载的服务器区分开来。

IDC 预计,2023 年全球服务器销量将下降 19.4%,仅略低于 1200 万台,但由于人工智能服务器的平均售价非常高,人工智能服务器的收入(基于去年对 2022 年人工智能服务器收入 98 亿美元的估计)增长了 3.2 倍,达到 313 亿美元,占市场份额的 23%。IDC 预计,到 2027 年,AI 服务器将带动 491 亿美元的销售额。IDC 没有透露其对 2027 年服务器收入的最新预测,但正如这里所显示的那样,截至 2023 年底,这一数字为 1891.4 亿美元。

顺便提一下,在 IDC 划分服务器市场时,使用 CPU 上的原生矩阵或矢量引擎在 CPU 上进行人工智能运算的机器不被视为加速型,无论如何,笔者认为对 2027 年人工智能服务器收入的预测过低,或者对 2027 年整体服务器收入的预测过高,或者两者兼而有之。到 2027 年,具有某种加速功能的人工智能服务器的收入占比或将略低于一半,而且笔者假设数据中心将出现大量的加速和生成式人工智能。

评论